「Develop」の版間の差分

(Other コメントの著者名) |

(拡張子、サンプルファイル) |

||

| (同じ利用者による、間の295版が非表示) | |||

| 3行目: | 3行目: | ||

== Other == | == Other == | ||

[https://asciiflow.com/#/ ASCIIFlow]: 画面構成図などの作成でテキストなので便利かもしれない。 | [https://asciiflow.com/#/ ASCIIFlow]: 画面構成図などの作成でテキストなので便利かもしれない。 | ||

=== Management === | |||

==== データ管理 ==== | |||

https://chatgpt.com/share/680a33a2-159c-800b-8e8f-020f3d9ac921 | |||

時間ベースとカテゴリーベースがある。それぞれ利点と欠点がある。 | |||

* カテゴリーベース: 検索・アクセスが有利。プロジェクト、業務単位。長期にわたって使うもの。 | |||

* 時間ベース: 保管・バックアップ効率。経理関係。一時保管など。 | |||

基本はカテゴリーベースで、契約書とか、一時保管が必要なものは、時間ベースにも保管する。こうすると、いいかもしれない。 | |||

コピーする場合、どこからどこのコピーかわかるように、ショートカットも配置しておく。また、コピーであることがわかるディレクトリーにしておく。 | |||

==== バックアップ ==== | |||

VCSなしの場合のバックアップファイルの命名規則。 | |||

https://grok.com/share/c2hhcmQtMw%3D%3D_28297f6a-2ff6-4a9d-af38-5e729e65d9ed | |||

filename.YYYYmmdd.ext | |||

この形式がいい。拡張子の前に日付を入れる。拡張子の後に入れてしまうと、アプリが拡張子を認識できなくて困る。 | |||

=== Project === | === Project === | ||

| 28行目: | 51行目: | ||

これでDoneをclose時にアーカイブ用のプロジェクトに移動できる。 | これでDoneをclose時にアーカイブ用のプロジェクトに移動できる。 | ||

=== | === Product === | ||

==== | ==== 会員番号の設計 ==== | ||

https://grok.com/share/c2hhcmQtMw%3D%3D_db01208a-8222-4d9b-900e-2bb429417296 | |||

ポイントカードは番号だけでためたり、使えたりしちゃう。流出すると不正利用の可能性がある。dポイントとか楽天ポイントとか。既存のポイントシステムは、固定番号を採用している。 | |||

アプリでタイムスタンプを付けたら、流出漏洩ガードができる。が、即時性を優先して固定番号も併用している模様。後は、不正監視システムでカバーとか。 | |||

ポイントは換金性が高いが、そんなに金額が大きくならずに消費される想定だから、リスクはあっても問題ない感じなのだと思われる。 | |||

==== | ==== バーコード ==== | ||

* [https://www.keyence.co.jp/ss/products/autoid/codereader/basic-types.jsp?msockid=39c0e5811530653525dcf3e014af64bb バーコードの種類 | バーコード講座 | キーエンス] | |||

* [https://github.com/zxing/zxing/ zxing/zxing: ZXing ("Zebra Crossing") barcode scanning library for Java, Android] | |||

形式が複数ある。 | |||

{| class="wikitable" | |||

!1D product | |||

!1D industrial | |||

!2D | |||

|- | |||

|UPC-A | |||

|Code39 | |||

|QR Code | |||

|- | |||

|UPC-E | |||

|Code93 | |||

|Data Matrix | |||

|- | |||

|EAN-8 | |||

|Code128 | |||

|Aztec | |||

|- | |||

|EAN-13 | |||

|Codabar | |||

|PDF 417 | |||

|- | |||

|UPC/EAN Extension 2/5 | |||

|ITF | |||

|MaxiCode | |||

|- | |||

| | |||

| | |||

|RSS-14 | |||

|- | |||

| | |||

| | |||

|RSS-Expanded | |||

|} | |||

==== 緯度経度の順番 ==== | |||

https://grok.com/share/c2hhcmQtMw%3D%3D_4f7c43b1-51f2-4cf4-b832-b108d74c7705 | |||

地理情報の座標は、緯度経度の順番で表記することが多い。ただ、数学的にはx,yの順番。メルカトル図法の一般的な地図の資格情報的には、経度緯度がx,yと対応する。順番が違うのが気になる。 | |||

結論: 外部公開APIは、緯度経度。内部で緯度経度を変換して、x,yにしたら、x,yの順番で扱う。 | |||

理由: 地理学的には、経度は特定が難しくて、緯度が先に特定されて、世界で先に使われるようになった。そのため、緯度経度の順番になって、世間で定着している。ISOなどの標準も緯度経度の順番。GeoJSONとかITシステムでは経度緯度の順番。 | |||

===== チェックイン機能 ===== | |||

==== | ====== 方式 ====== | ||

<nowiki>https://grok.com/share/c2hhcmQtMw%3D%3D_792c1e8e-5fcd-429b-a7cd-1e116addbf39</nowiki> | |||

{| class="wikitable" | |||

<nowiki> | |+ | ||

!方式 | |||

!内容 | |||

!利点 | |||

!欠点 | |||

!不正 | |||

!対策 | |||

|- | |||

|Geolocation API | |||

|店舗でマイページボタン押下 | |||

|追加設備不要 | |||

|不正完全防止不能 | |||

|位置偽装 | |||

|ユーザー特定可能なので、運用で不正をカバーする。 | |||

|- | |||

|動的QR | |||

|店頭動的QRコードの読取 | |||

|不正完全防止 | |||

|表示端末設置必要、サーバー追加実装必要 | |||

| | |||

| | |||

|- | |||

|固定QR | |||

|店頭固定QRコード読取 | |||

|サーバー追加実装不要 | |||

|不正完全防止不能 | |||

|QRコード撮影持帰 | |||

|固定QRを定期更新。 | |||

|- | |||

|NFC | |||

|店頭NFC読取 | |||

| | |||

|タグ設置必要、端末限定 | |||

| | |||

| | |||

|- | |||

|Bluetooth Beacon | |||

|店頭Beacon通信 | |||

| | |||

|Beacon設置必要 | |||

| | |||

| | |||

|} | |||

https:/ | * 手間最小はGeolocation API。位置偽装がありえるので、アカウントの定期監視は必要。付与の頻度や上限の制限ロックなど必要。 | ||

* 不正防止+低コストは固定QR。定期的なQR更新が必要。 | |||

* 不正完全防止で手間最小は動的QR。ただし、表示端末設置、追加サーバー実装必要。 | |||

====== 動的QR ====== | |||

https://grok.com/share/c2hhcmQtMw%3D%3D_57855e1c-bae0-4fd9-99f5-622979149ff3 | |||

トークン管理用のテーブルを用意。 | |||

CREATE TABLE checkin_history ( | |||

id INT AUTO_INCREMENT PRIMARY KEY, | |||

store_id INT NOT NULL, | |||

token VARCHAR(255) NOT NULL, | |||

checkin_at TIMESTAMP DEFAULT CURRENT_TIMESTAMP, | |||

FOREIGN KEY (store_id) REFERENCES stores(store_id) | |||

); | |||

トークン作成用のAPIを用意。アクセスが来たら、tokenを作って、それや店舗IDを埋め込んだQR/URLを作成 (?store_id=XXX&token=XXX)。 | |||

該当トークンを検証して、処理実施。GPS不要になる。 | |||

== Communication == | |||

=== Backlog === | |||

==== メール通知 ==== | |||

[https://yoshikazu-komatsu.com/backlog-notification-customize-guide/ Backlogの通知設定をカスタマイズする手順|チーム効率を2倍にする最適化テクニック | こまろぐ] | |||

[個人設定]-[メール設定] で全体設定する。 | |||

ただ、コメント記入時に、[コメントをお知らせしたいユーザー] に入っていると、通知が来る。メールフィルターで対応するしかない。 | |||

=== Skype === | |||

[https://support.microsoft.com/ja-jp/skype/%E3%81%99%E3%81%B9%E3%81%A6%E3%81%AE%E3%82%A8%E3%83%A2%E3%83%BC%E3%83%86%E3%82%A3%E3%82%B3%E3%83%B3%E3%81%AE%E3%83%AA%E3%82%B9%E3%83%88%E3%81%AF%E3%81%82%E3%82%8A%E3%81%BE%E3%81%99%E3%81%8B-01af0c65-529f-4a4d-8e3a-a393033a359a すべてのエモーティコンのリストはありますか? - Microsoft サポート] | |||

Skyepで使用可能な絵文字の一覧。 | |||

=== | === Slack === | ||

==== チャンネル ==== | |||

https://slack.com/intl/ja-jp/help/articles/205239967-%E3%83%81%E3%83%A3%E3%83%B3%E3%83%8D%E3%83%AB%E3%81%AB%E5%8F%82%E5%8A%A0%E3%81%99%E3%82%8B | |||

===== 一覧表示 ===== | |||

[ホーム]-[チャンネル]-[管理する]-[チャンネル一覧] でチャンネル一覧を閲覧可能。 | |||

==== パーマリンク ==== | |||

=== | Slackの投稿パーマリンクをWebブラウザーで開くと、該当箇所にジャンプできない。デスクトップアプリがあると開ける。それでしのぐ。 | ||

=== JIRA === | |||

==== | ==== 関連チケット ==== | ||

/[ | [修正するバージョン]/[影響するバージョン] のリンクをクリックすると、関連するissueが一覧表示される。これで未クローズチケットを確認するといい。 | ||

===== | ==== 履歴 ==== | ||

[アクティビティ]-[履歴] のタブを選ぶと、変更履歴を確認できる。 | |||

=== | === Confluence === | ||

ページの中で、 [作成] を選んでページを作ると、階層が勝手にできて、子ページへのリンクもできる。 | |||

=== | ==== ショートカットキー ==== | ||

キーボード ショートカット | |||

https://ja.confluence.atlassian.com/doc/keyboard-shortcuts-139456.html | |||

===== エディタ ===== | |||

* {code: コードブロック (https://shinkufencer.hateblo.jp/entry/2018/10/17/235900 Confluenceのエディタは { でマクロのショートカット入力ができるし、{ code } でコードスニペット領域が作れる)。 | |||

ブロック フォーマット | |||

{| class="wikitable" | |||

!Windows | |||

!操作 | |||

!Mac | |||

|- | |||

|Ctrl + 0 | |||

|Paragraph | |||

|⌘+ 0 | |||

|- | |||

|Ctrl+ (1 ~ 6) | |||

|(選択した番号の)見出しレベル | |||

|⌘+ (1—6) | |||

|- | |||

|Ctrl + 7 | |||

|Preformatted | |||

|⌘+ 7 | |||

|- | |||

|Ctrl + 8 | |||

|Quote | |||

|⌘+ 8 | |||

|- | |||

|Ctrl + Shift + B、または | |||

<nowiki>*</nowiki> + Space | |||

|箇条書きリストを追加 | |||

|⌘ + Shift + B、または | |||

<nowiki>*</nowiki> + Space | |||

|- | |||

|Ctrl + Shift + N、または | |||

<nowiki>#</nowiki> + space | |||

|番号付きリストを追加 | |||

|⌘ + Shift + N、または | |||

<nowiki>#</nowiki> + space | |||

|- | |||

|Ctrl + Shift + S | |||

|Strikethrough | |||

|⌘ + Shift + S | |||

|- | |||

|Ctrl + Shift + | |||

|Subscript | |||

|⌘ + Shift + , | |||

|- | |||

|Ctrl + Shift + | |||

|Superscript | |||

|⌘ + Shift + . | |||

|- | |||

|Ctrl + Shift + M | |||

|Monospace | |||

|⌘ + Shift + M | |||

|- | |||

|Ctrl + \ | |||

|Clear formatting | |||

|⌘ + \ | |||

|} | |||

豊富なフォーマット | |||

{| class="wikitable" | |||

|CTRL + Shift + V | |||

''サファリのみ:''Ctrl + Shift + Alt + V | |||

|書式設定なしでテキストを貼り付け | |||

|⌘ + Shift + V | |||

''Safari のみ:''⌘ + Shift + Option + V | |||

|- | |||

|Ctrl+M | |||

|Files and images | |||

|⌘+ M | |||

|- | |||

|Ctrl+K | |||

|リンク([リンクの挿入] ダイアログが開く) | |||

|⌘ + K | |||

|- | |||

|Ctrl + Shift + D | |||

|マークアップを挿入([マークアップの挿入] ダイアログが開く) | |||

|⌘ + Shift + D | |||

|- | |||

|Ctrl+Shift+A | |||

|マクロ([マクロの選択] ダイアログが開く) | |||

|⌘ + Shift + A | |||

|- | |||

|Ctrl + Shift + O | |||

|次のインライン コメントに切り替え | |||

|⌘ + Shift + O | |||

|- | |||

|Ctrl + Shift + L | |||

|前のインライン コメントに切り替え | |||

|⌘ + Shift + L | |||

|- | |||

|CTRL + Shift + Z | |||

|インライン コメントを閉じる | |||

|⌘ + Shift + Z | |||

|- | |||

|Ctrl + Shift + I | |||

|表 | |||

|⌘ + Shift + I | |||

|- | |||

|Alt + 上矢印 | |||

|行を上に挿入 | |||

|Alt + 上矢印 | |||

|- | |||

|Alt + 下矢印 | |||

|下に行を挿入 | |||

|Alt + 下矢印 | |||

|- | |||

|Ctrl + Shift + X | |||

|行を切り取り | |||

|⌘ + Shift + X | |||

|- | |||

|Ctrl + Shift + C | |||

|行をコピー | |||

|⌘ + Shift + C | |||

|- | |||

|Ctrl + Shift + Y | |||

|行を上に貼り付け | |||

|⌘ + Shift + Y | |||

|- | |||

|Ctrl + Shift + ; | |||

|絵文字メニュー | |||

|⌘ + Shift + ; | |||

|- | |||

|CTRL + Shift + V | |||

|書式設定なしで貼り付け | |||

|⌘ + Shift + V | |||

|- | |||

| | |||

|書式設定なしで貼り付け (Safari) | |||

|⌘ + Shift + Option + V | |||

|} | |||

===== オートコンプリート ===== | |||

[] が勝手にリンクになるのが困る。 | |||

リンク、ファイル、マクロ、メンション、絵文字のオートコンプリート | |||

https://ja.confluence.atlassian.com/doc/autocomplete-for-links-files-macros-mentions-and-emojis-249858190.html | |||

オートコンプリートの無効化方法。 | |||

プロフィール画像を選択-[設定]-[エディター]-[☑️オートコンプリートの無効化] | |||

ただ、オートコンプリートの丸ごと無効化は、便利な機能がなくなるので不味い。 | |||

一時的に回避したい場合、[の直前に何か文字があれば解釈されない。スペース開けて[があるとオートコンプリート扱いになる。 | |||

===== 書式なしペースト ===== | |||

[https://qiita.com/kentoak/items/fbba0b9e3e735893a35e Confluenceで書式なしペースト(Ctrl+Shift+V)を有効にする #Confluence - Qiita] | |||

[?]-[キーボードショートカット]-[General]-[▫️Enable General Shortcuts] にしてオフにすると有効になる。 | |||

[表の上部にペースト] と競合していたらしい。 | |||

==== マクロ ==== | |||

[https://ja.confluence.atlassian.com/doc/macros-139387.html マクロ | Confluence Data Center 9.2 | アトラシアン製品ドキュメント] | |||

いくつか有用なマクロがある。 | |||

* [https://ja.confluence.atlassian.com/doc/children-display-macro-139501.html 子ページ表示マクロ | Confluence Data Center 9.2 | アトラシアン製品ドキュメント] | |||

* [https://www.ricksoft.jp/blog/articles/001510.html Confluence(コンフルエンス)の一部内容を折りたたみで非表示できる「展開」マクロを使ってみよう - リックソフトブログ] | |||

==== Other ==== | |||

===== パーマリンク ===== | |||

[https://confluence.atlassian.com/confkb/the-differences-between-various-url-formats-for-a-confluence-page-278692715.html The Differences Between Various URL Formats for a Confluence Page | Confluence | Atlassian Documentation] | |||

Confluenceのページ新規作成時、パーマリンクが自動生成される。規則がある。 | |||

以下の条件にマッチしたら、padeId URLになる。それ以外は、タイトル名のURLになる。 | |||

* [% & ? / ¥ ; " + :] などのようなURLの予約文字。 | |||

* 非ラテン文字。 | |||

* ページタイトル末尾が英数字以外の場合。 | |||

===== ページ履歴 ===== | |||

ページ右上のメニュー-[ページ履歴]から履歴を確認できる。差分も確認できる。 | |||

===== ページ移動 ===== | |||

[https://ja.confluence.atlassian.com/doc/move-and-reorder-pages-146407727.html ページの移動と順序の変更 | Confluence Data Center 9.2 | アトラシアン製品ドキュメント] | |||

ページ右上のメニュー-[移動] | |||

== Tool == | |||

=== General === | |||

=== | ==== Call tree ==== | ||

kcachegrindだったかな。 | |||

kscopeもこれか。 | |||

Doxygen+GraphVizで関数コールグラフ | |||

==== kscope ==== | |||

https:/github.com/ivan0124/Linux-programming/wiki/How-to-use-KScope-to-trace-code | |||

https:/sourceforge.net/projects/kscope/ | |||

http:/www.lemis.com/grog/software/kscope.php | |||

==== cscope ==== | |||

cbrowser/kbrowserというGUIもある。 | |||

cscopeの大文字小文字無視検索 | |||

<nowiki>http://vim.1045645.n5.nabble.com/how-to-search-with-cscope-ignoring-case-td5715043.html</nowiki> | |||

DBを別にする必要がありそう。 | |||

==== expect ==== | |||

端末の手動操作を自動化するソフト。 | |||

* <nowiki>*</nowiki> ^と$は使えない。代わりに、\nを使う。 | |||

* <nowiki>*</nowiki> 文字列の囲みに一重引用符 (') は使えない。二重引用符 (") のみ有効。 | |||

* <nowiki>*</nowiki> expect文はawkみたいな感じ。 | |||

* <nowiki>*</nowiki> ただし、expectは注意が必要。最初のexpectにマッチしないと先に進めない。タイムアウトとかするしかない。 | |||

expect -c "set timeout 5; spawn cat cat.txt; expect \nFAIL {send pwd/n; expect :; exit}" | |||

https:/linuxjm.osdn.jp/html/expect/man1/expect.1.html | |||

sh -eux <<-"EOT" | |||

expect -c "set timeout 5; spawn ssh senooken@senooken-linux; expect :; send ieneko/n; expect aho {send echo aho} +x {send pwd/n}; expect /$; exit" | |||

expect -c "set timeout 5; spawn ssh senooken@senooken-linux; expect :; send ieneko/n; expect + {send pwd/n}; expect /$; exit" | |||

expect -c "set timeout 5; spawn cat cat.txt; expect \nFAIL {send pwd/n; expect :; exit}" | |||

expect -c 'set timeout 10; spawn cat cat.txt; expect "aa F" {set AAA "abc"}; expect FAIL {send "$AAA/n"; expect " "; exit}' | |||

EOT | |||

===== 踏み台サーバーログイン ===== | |||

expectのオプションに-cで細切れにするのもOK | |||

<nowiki> </nowiki> | |||

connect 'xxx.xxx.xxx.xxx /ssh /auth=password /user=id /passwd=pw' | |||

wait <nowiki>''</nowiki> | |||

sendln 'ssh root@<ここにIPアドレスを記入>' | |||

wait 'Password:' | |||

sendln 'pw' | |||

connect 'ip1 /ssh /auth=password /user=sef19a /passwd=ipscp19a' | |||

wait <nowiki>''</nowiki> | |||

sendln 'expect -c "spawn ssh root@ip2; expect :; send pelican/n; interact"' | |||

sendln 'expect -c "spawn ssh root@ip2" -c "expect :" -c "send pelican/n" -c "interact"' | |||

==== | ==== GNU screen ==== | ||

[https://qiita.com/SAITO_Keita/items/b79ebc5af64aad28fc4a#:~:text=%E3%82%B9%E3%82%AF%E3%83%AA%E3%83%BC%E3%83%B3%E3%82%BB%E3%83%83%E3%82%B7%E3%83%A7%E3%83%B3%E3%81%AB%E6%8E%A5%E7%B6%9A%E3%81%97%E3%81%A6%E3%81%84%E3%82%8B%E7%8A%B6%E6%85%8B%E3%81%A7%E3%82%AD%E3%83%BC,%E6%A8%AA%E3%81%AB%E5%88%86%E5%89%B2%E3%81%A7%E3%81%8D%E3%81%BE%E3%81%99%E3%80%82 GNU Screenコマンドをつかってみる #screen - Qiita] | |||

screenコマンド実行後に、C-a押下後に対応するキーを押して各種操作を実行する。 | |||

キー操作以外に、コマンドも用意されている。C-a :でコマンドラインモードに入る。 | |||

==== | 特に重要な操作。 | ||

* Help | |||

** C-a ? | |||

** Command:help | |||

* Window | |||

** C-a c/C-a C/Command:screen=Windowを生成。 | |||

** C-a space/C-a n/C-a C-n/Command:next=次のWindowへ移動。 | |||

** C-a p/C-a C-p/C-a C-h/C-a Backspace/Command:prev=前のWindowへ移動。 | |||

* 画面分割: Regionを分割してそこにWindowを割り当てる。 | |||

** C-a S=横分割 | |||

** C-a |=縦分割 | |||

** C-a TAB/Command:focus=分割画面の移動。 | |||

* クローズ | |||

** C-a X/Command:remove=現在のRegionを終了。 | |||

** C-a Q/Command:Only=現在以外のRegionを終了。 | |||

===== .screenrc ===== | |||

====== スタートアップメッセージ ====== | |||

startup_message off | |||

====== スクロール ====== | |||

[https://www.robotech-note.com/entry/2017/01/27/082929 linux screen中にマウスホイールでスクロールする方法 - 技術メモ集] | |||

デフォルトだとマウススクロールなどに対応していない。以下の設定で対応でき、通常使用で問題なくなる。 | |||

termcapinfo xterm* ti@:te@ | |||

defscrollback 100000 | |||

=== File === | |||

==== Binary ==== | |||

===== .so ===== | |||

ソフトウェアの依存関係などの調査で.soファイルの分析を行うことがある。 | |||

[https://zenn.dev/nyoho/scraps/3651de0bd0b313 .soファイルの中のシンボル探し] | |||

* nm | |||

* ldd | |||

* string | |||

==== 設定ファイル ==== | |||

https://grok.com/share/c2hhcmQtMw%3D%3D_fb839660-c036-4484-b24f-aa77107db9b3 | |||

xml/json/yaml/iniなど設定ファイルの形式がいろいろある。それぞれ長所短所があって使い分けがある。 | |||

* json: パースが高速。コメント未対応。複雑な構文をサポート可能で、データの交換などで使う。 | |||

* xml: 表現力が高い。が、パースはjsonよりは遅い。名前空間など意味論の厳密性が必要な時。 | |||

* yaml: 可読性が高い。コメント対応。人間が頻繁に編集するタイプのデータに使う。 | |||

* ini: シンプルで高速。ネストの表現不能。単純なキーバリューのシンプルな設定だけ。 | |||

* toml | |||

* HCL (HashiCorp Configuration Language) | |||

* Protocol Buffers (Protobuf) | |||

* EDN (Extensible Data Notation) | |||

* CSV | |||

yamlかjsonで作っておくと無難。 | |||

==== YAML ==== | |||

===== About ===== | |||

* [https://ja.wikipedia.org/wiki/YAML YAML - Wikipedia] | |||

* [https://yaml.org/ The Official YAML Web Site] | |||

YAML 1.2.2 (2021-10-01) が最新。2001-05-11が初版。dockerなどの設定ファイルで採用されていて一部で人気。可読性が高くて、コメントを記入できて、データ量も少ない。人が手作業で記入する形式として適しているとの評判。 | |||

YAML Ain’t Markup Language (YAML™) | |||

===== Basic ===== | |||

====== General ====== | |||

インデントで階層構造を表現。インデントはスペースのみ。スペース2個でインデントが主流。 | |||

<nowiki>#</nowiki>は行コメント。 | |||

---は1ファイル内に複数YAML記載時のセパレーター | |||

====== リスト ====== | |||

ブロック形式とインライン形式/フロー形式の2種類の記載方法がある。 | |||

--- # お好みの映画、ブロック形式 | |||

- Casablanca | |||

- Spellbound | |||

- Notorious | |||

--- # 買い物リスト、インライン形式、またはフロー形式 | |||

[milk, bread, eggs] | |||

- {name: John Smith, age: 33} | |||

- name: Mary Smith | |||

age: 27 | |||

ハッシュのリストのブロック形式はバレットが1個しかつかないのでちょっと気持ち悪いので注意。 | |||

====== 連想配列・ハッシュ ====== | |||

--- # ブロック | |||

name: John Smith | |||

age: 33 | |||

--- # インライン | |||

{name: John Smith, age: 33} | |||

men: [John Smith, Bill Jones] | |||

women: | |||

- Mary Smith | |||

- Susan Williams | |||

リストのハッシュ。 | |||

====== Scalars ====== | |||

1文字目を|にして改行すると、データ内の改行を維持。>にすると、改行をスペースに置換。 | |||

data: | | |||

There was a young fellow of Warwick | |||

Who had reason for feeling euphoric | |||

For he could, by election | |||

Have triune erection | |||

Ionic, Corinthian, and Doric | |||

data: > | |||

Wrapped text | |||

will be folded | |||

into a single | |||

paragraph | |||

Blank lines denote | |||

paragraph breaks | |||

=== | ===== Other ===== | ||

==== | ====== ブロック/インライン・フローの混在 ====== | ||

Swaggerのプロパティーのdescriptionで区分値の説明用に箇条書きを使いたい。 | |||

content: | |||

application/json: | |||

schema: | |||

type: "object" | |||

required: ["customerNo", "eventNo"] | |||

properties: | |||

customerNo: {title: "会員番号", description: "会員番号", type: string} | |||

actionType: | |||

title: アクションタイプ | |||

description: | | |||

ユーザーのアクション種別。 | |||

- 1: セミナー申込 | |||

- 2: 動画視聴, | |||

type: integer | |||

enum: [1, 2] | |||

default: 1 | |||

基本はswaggerやyamlはブロック形式が基本になっている。短くてシンプルなところだけインライン・フロー形式を使う。長くなるならブロック形式にする。 | |||

親のpropertiesのブロック形式にする必要がある。 | |||

==== | === Diff === | ||

差分確認ツール。コードレビューなどで重要。 | |||

=== | ==== About ==== | ||

Macが鬼門。 | |||

M1 Macで使用可能なものの選択肢が極端に狭い。 | |||

https://chatgpt.com/c/678e249e-84f0-800b-b8da-7385d9aaf819 | |||

{| class="wikitable" | |||

|+ | |||

!name | |||

!OS | |||

!Free | |||

!GUI | |||

!directory | |||

!image | |||

!comment | |||

https:// | |- | ||

|FileMerge | |||

|Mac | |||

|x | |||

|x | |||

|x | |||

| | |||

|Xcode付属ツール。悪くない。が、Mac専用。 | |||

|- | |||

|P4Merge | |||

|x | |||

|x | |||

|x | |||

| - | |||

|x | |||

|ディレクトリー比較ができないのが惜しい。 | |||

|- | |||

|DiffMerge | |||

|x | |||

|x | |||

|x | |||

|x | |||

| - | |||

|悪くない。が開発停止。MacはIntel版のみ。 | |||

|- | |||

|WinMerge | |||

|Windows | |||

|x | |||

|x | |||

|x | |||

| | |||

|使いやすい。 | |||

|- | |||

|Meld | |||

|Windows/Linux | |||

|x | |||

|x | |||

|x | |||

| | |||

|Linux系の標準。悪くない。 | |||

|- | |||

|kdiff3 | |||

|Windows/Linux | |||

|x | |||

|x | |||

|x | |||

| | |||

|開発停止。使えなくはない。 | |||

|- | |||

|vimdiff | |||

|x | |||

|x | |||

|x | |||

|x | |||

| - | |||

|使いにくい。 | |||

|- | |||

|Visual Studio Code | |||

|x | |||

|x | |||

|x | |||

|x | |||

|x | |||

|ディレクトリー比較は [[https://marketplace.visualstudio.com/items?itemName=moshfeu.compare-folders Compare Folders - Visual Studio Marketplace]] 拡張機能。 画像比較は [Image Preview] らしい。 | |||

|- | |||

|Intellij IDARE | |||

|x | |||

| - | |||

|x | |||

|x | |||

|x | |||

| | |||

|- | |||

|Beyond Compare | |||

|x | |||

| - | |||

|x | |||

|x | |||

|x | |||

| | |||

|- | |||

|DiffImg | |||

|Windows/Linux | |||

|x | |||

|x | |||

| | |||

|x | |||

| | |||

|- | |||

|PerceptuallDiff | |||

|x | |||

| | |||

| - | |||

| | |||

|x | |||

| | |||

|- | |||

|PixelCompare | |||

| | |||

| | |||

|x | |||

| | |||

|x | |||

| | |||

|} | |||

DiffMerge一択になる。ファイルサイズも小さい。大きくても11 MB。 | |||

Visual Studio Codeが汎用的だから、こちらでいいかもしれない。 | |||

==== DiffMerge ==== | |||

[https://note.com/modern_ferret431/n/nbb5061ddf08c mac で WinMerge |東京 AI 研究所] | |||

=== | ==== FileMerge ==== | ||

[https://reasonable-code.com/filemerge/ Mac純正のファイル差分確認ツール「FileMerge」が使いやすい - Reasonable Code] | |||

[/Applications/Xcode.app]-右クリック-[Show content]-[Contents/Applications/FileMerge.app] | |||

コマンドラインからだとopendiff。 | |||

==== Visual Studio Code ==== | |||

===== About ===== | |||

ディレクトリー比較は [[https://marketplace.visualstudio.com/items?itemName=moshfeu.compare-folders Compare Folders - Visual Studio Marketplace]] 拡張機能。 画像比較は [Image Preview] らしい。 | |||

[https://www.javadrive.jp/vscode/editor/index3.html VSCode | 2つのファイルの内容を比較して差分を表示する] | |||

code -d <file1> <file2> | |||

上記コマンドで差分表示できる。外部の差分ツールとして使う際は、上記コマンドになるように指定する。 | |||

GUIからだと、[View]-[Command Pallete]-[Compare] から比較できる。 | |||

比較のモードがいくつかある ([https://zenn.dev/haretokidoki/articles/dae3536ea55f49 VS Codeでファイル・ソースコードの差分を比較(diff)する2通りの方法])。 | |||

https:// | {| class="wikitable" | ||

!No. | |||

!比較モード | |||

!用途 | |||

|- | |||

|1 | |||

|ファイル: アクティブ ファイルを比較しています... | |||

File: Compare Active File With... | |||

|現在のアクティブファイル と 指定したファイル を比較する。 | |||

|- | |||

|2 | |||

|ファイル: クリップボードとアクティブ ファイルを比較 | |||

File: Compare Active File with Clipboard | |||

|<code>Ctrl + C</code>でクリップボードに保存された文字列 と 現在のアクティブファイル を比較する。 | |||

|- | |||

|3 | |||

|ファイル: 新しい無題のテキスト ファイルの比較 | |||

File: Compare New Untitled Text Files | |||

|比較モードで新規テキストファイルを2つ開いた状態となる。 | |||

|- | |||

|4 | |||

|ファイル: 保存済みファイルと作業中のファイルを比較 | |||

File: Compare Active File with Saved | |||

|未編集状態のアクティブファイル と 前回保存したアクティブファイル を比較する。 | |||

|- | |||

|5 | |||

|マージの場合: 現在の競合を比較 | |||

Merge Conflict: Compare Current Conflict | |||

|Git環境でブランチをマージした時にコンリクト(競合)が発生していないか比較する。 | |||

|} | |||

File: Compare Active File Withが素直か。 | |||

===== Diff Folders ===== | |||

[https://untic.blog/blogs/468 VSCode拡張機能「Diff Folders」でフォルダ間の違いを簡単に比較しよう! | UNTIC | Web担当者のための仕事メディア] | |||

Diff Foldersの他に、Compare Foldersというのもある。が、Diff Foldersのほうが直感的で使いやすいらしい ([https://stackoverflow.com/questions/70159358/is-there-a-compare-folders-feature-in-vs-code is there a compare folders feature in VS Code? - Stack Overflow])。ただ、Compare Foldersのほうがダウンロード数が多い。 | |||

標準ではディレクトリー比較はできない。Diff Foldersの拡張機能が必要。 | |||

# Diff Foldersをインストール | |||

# c-P-[Diff Folders]-[New Diff Panel] またはc-L | |||

===== Compare Folders ===== | |||

[https://amateur-engineer-blog.com/vscode-compare-folders VSCodeでフォルダ丸ごと比較する] | |||

=== | ==== format ==== | ||

[https://qiita.com/bitnz/items/725350b614bafedc581a わかりやすい差分(diff)の取り方いろいろメモ #Git - Qiita] | |||

diffコマンドの差分表示の形式がいくつかある。 | |||

# ノーマル | |||

# context | |||

# unified | |||

contextとunified形式には差分に対象ファイルの情報がある。パッチファイルを作成するなら、この2種にすべきになる。 | |||

ノーマル形式は、本当に変更行のピンポイントの情報だけ。 | |||

===== normal ===== | |||

the | |||

quick | |||

brown | |||

fox | |||

jumps | |||

over | |||

the | |||

lazy | |||

dog | |||

the | |||

quick | |||

brown | |||

fox | |||

jumped | |||

over | |||

the | |||

lazy | |||

dogs | |||

=== | % diff a.txt b.txt | ||

5,6c5 | |||

< | |||

< jumps | |||

--- | |||

> jumped | |||

8a8 | |||

> | |||

10c10 | |||

< dog | |||

--- | |||

> dogs | |||

5,6行目と5行目で開業+jumpsのjumpedへの変更 (c=changed)。d=deleted。a=added。こういう形式。 | |||

* | ===== context ===== | ||

* | % diff -c a.txt b.txt | ||

*** a.txt 2016-08-29 06:43:45.000000000 +0900 | |||

--- b.txt 2016-08-29 06:43:59.000000000 +0900 | |||

*************** | |||

*** 2,10 **** | |||

quick | |||

brown | |||

fox | |||

! | |||

! jumps | |||

over | |||

the | |||

lazy | |||

! dog | |||

--- 2,10 ---- | |||

quick | |||

brown | |||

fox | |||

! jumped | |||

over | |||

the | |||

+ | |||

lazy | |||

! dogs | |||

2行目から10行目にかけて。 | |||

!は変更。+は追加。 | |||

===== unified ===== | |||

[https://den8.hatenadiary.org/entry/20100622/1277226958 diffによるunified形式の意味について - プログラミング以外 - k.bigwheelの日記] | |||

gitなど差分ツールでよく使われるunified形式。形式が独特で知っていないと意味不明なので注意する。diff -uオプションでこの形式になる。 | |||

$ diff -u test.txt.orig test.txt | |||

--- test.txt.orig 2007-06-10 22:13:55.718311614 +0900 | |||

+++ test.txt 2007-06-10 22:54:23.038008776 +0900 | |||

@@ -2,9 +2,10 @@ | |||

かきくけこ | |||

さしすせそ | |||

たちつてと | |||

-なにぬねの | |||

+なにぬねのん | |||

はひふへほ | |||

まみむめも | |||

やゆよ | |||

らりるれろ | |||

わをん | |||

+がぎぐげご | |||

@@の行がが特に重要。 | |||

@@ -R +R @@ | |||

この書式。-Rが元ファイルの変更箇所、+Rが変更後ファイルの変更箇所。 | |||

Rはl,sという形式。lは変更箇所の開始行、sは変更箇所の行数。 | |||

-2,9は2行目から9行分変更箇所がある。という意味。 | |||

変更箇所の前後の情報を@@で表現している。 | |||

ただ、このunified形式は中途半端。視認性重視。 | |||

===== 2カラム ===== | |||

diff -yかicdiff --line--numbersは2列で表示してくれるから、視認性が高い。 | |||

==== | == UML == | ||

=== Tool === | |||

https://chatgpt.com/c/67441feb-d004-800b-96fd-0d9b04ffc628 | |||

[https://www.quora.com/What-are-the-best-UML-tools-for-macOS What are the best UML tools for macOS? - Quora] | |||

* デスクトップ | |||

** StarUML | |||

** ArgoUML | |||

** UMLet | |||

** OmniGraffle | |||

** edraw: 有料。 | |||

** Umbrello | |||

** Modelio | |||

* クラウド | |||

** Visual Paradigm | |||

** Lucidchart: 有料。 | |||

** Creately: 有料。 | |||

** diagrams.net: モデルじゃない。 | |||

*その他 | |||

**PlantUML | |||

UmbrelloとModelioはそれらと比較して何がよかったのだっけ? | |||

Eclipse Papyrusが動作するならこれがいい。Eclipseは安定しているから、これのプラグインで動作するなら信頼できるだろう。 | |||

papyrusは一度試してダメだった気がするが。 | |||

=== Diagram === | |||

==== クラス図 ==== | |||

A=自分 (矢印の元)。B=相手 (矢印の先) | |||

* 継承関係 | |||

** 汎化 (generalization): 実線白矢印。継承。 | |||

** 実現 (realization): 点線矢印。interfaceの継承。 | |||

* プロパティー単位 | |||

**関連 (association): 実線。あるクラスが他のクラスのインスタンスを持つ。ただし、所有までいかない。コンストラクターのDIも含む。人と車のように全体-部分の関係がない場合これ。困ったらこれでもいい。 | |||

** 集約 (aggregation): 白菱形実線。関連の特殊系。所有者の方が菱形。所有される側は線。全体-部分の関係。ただし、部分は他の全体からも共有可能。List<T>やSet<T>のメンバー変数があれば集約の可能性が高い。 | |||

** コンポジション (composition): 黒ひし形。子が単体で存在できない場合。親と生存期間が同一の場合。部分が他から共有されない。集約の特殊系。 | |||

** リンク (link): 実線。クラスのインスタンス間の関係。クラス図ではなく、オブジェクト図で使われる。 | |||

* メソッド単位 | |||

** 依存 (dependency): 点線矢印。引数か返却値に使っていて、Bの変更が影響を与える場合。 | |||

** 使用 (usage): 点線矢印。引数と戻り値に使わず、関数内で一時的に使うだけ。依存の特殊系。 | |||

==== | ==== ER図 ==== | ||

https:// | https://grok.com/share/c2hhcmQtMw%3D%3D_49664566-4833-490d-9309-e69597a6ac12 | ||

実態関連モデル。Entity-Relationshp Model。関係データベースを抽象的な表現手法。 | |||

格納されたデータが、他のデータとどう関係しているかを表現する。 | |||

1975年にPeter Chenが発表した。 | |||

* | * Entyty/実体: 現実世界のものや概念相当。オブジェクト指向のオブジェクト相当。DBではテーブル相当。四角形で描画。 | ||

* | * Attribute/属性: Entityの特徴や詳細情報。オブジェクト指向のプロパティー。DBではテーブルカラム相当。楕円で描画。 | ||

* Relationship/関係: Entity同士のつながり。オブジェクト指向のメソッド?DBではテーブル間の関係 (外部キーによるリンク相当)。菱形で描画。 | |||

* Instance/インスタンス: DBのレコード (行) 相当。 | |||

===== Relationship ===== | |||

https://grok.com/share/c2hhcmQtMw%3D%3D_861bd847-f9c8-4c01-8887-9802dad8f6e3 | |||

関係がわかりにくいので整理する。 | |||

Entity (テーブル相当) 動詞の関係をカーディナリティー (多重度) で表現する。3個の関係がある。 | |||

{| class="wikitable" | |||

|+ | |||

!関係 | |||

!関係名 | |||

!例 | |||

!意味 | |||

! | |||

|- | |||

|1:1 (One-to-One) | |||

|<Master> has one <Master> | |||

|Person/Passport: 1人1パスポート。それぞれ重複がない。PassportにPersonの外部キーを持つ。 | |||

Employee/EmployeeDetail: EmployeeDetailのEmployeeの外部キーを持つ。 | |||

|一方のEntityのインスタンス (行) がもう一方のEntityの1個だけのインスタンスに対応し、逆も同じ場合。情報が密接に関連していて、分離する必要はないが、管理・整理のために分けるケース。 | |||

詳細テーブルのパターン。テーブルに持ってもいいが、整理のために別テーブルにしている。 | |||

1:多の特殊ケースとみなせる。 | |||

実際のところ、1:1が本当に対等ということはほぼない。外部キーを片方に持たせる都合、親子関係がある。子が1個だけという話。逆に、そうできていないなら、Entityの選定・設計の問題を疑ったほうがいい。 | |||

| | |||

|- | |||

|1:多 (One-to-Many) | |||

|<Master> has <Transactions> | |||

|Department/Employee: Departmentが親でEmployeeが子。Departmentの1行 (ID=営業部) を、Employeeの複数行 (所属従業員) に対応。1従業員1所属の場合。EmployeeにDepartment IDを外部キーとして持つ。親の部門を削除すると子の従業員も影響を受ける。 | |||

Customer/Order: Customer (ID=1のA) はOrderの複数行 (注文1-3) に対応。注文は1顧客だけに連動。 | |||

|一方のEntityのInstanceがもう一方のEntityの複数のインスタンスに対応。逆は多:1だが、1:多でどちらも表現。親子関係のような階層構造で使用する。マスター:トランザクションの関係でも使う。 | |||

| | |||

|- | |||

|多:多 (Many-to-Many) | |||

|<Master> has many <Master> | |||

|Stundent/Course: Stundentの1行 (ID=1 学生A) はCourseの複数行 (数学、英語) に対応。Courseの1行 (数学) はStundentの複数行 (学生A,B,C) に対応。実装時はEnrollmentテーブル (登録) を作成して、これにStundent IDとCourse IDの相関テーブル+追加情報 (成績) などを入れる。 | |||

Product (製品)/Supplier (仕入先): 1商品が複数仕入れ先から調達可能。1仕入れ先が複数商品を供給。 | |||

|一方のEntityがもう一方の複数のEntityに対応。逆も同じ。両側が独立して複数関連づく場合。DBでは直接実装不能なので、中間テーブルを通常使う。2個の1:多に分解。 | |||

| | |||

|} | |||

マスターテーブルは親的な役割。トランザクションテーブルは子的な関係。通常、マスターテーブル:トランザクションテーブル=1:多。トランザクションテーブルにマスターテーブルの外部キーを持つ。 | |||

関係の命名。業務ロジックにあった命名ができればべストだが、一貫性がない。関係からある程度機械的に名前を決める。 | |||

* 1:1=has one | |||

* 1:多=has | |||

* 多:多=has many | |||

これがスマート。多対多はis related toもよく使うが、他をhasで表現するなら、こうしないと気持ち悪い。 | |||

=== PlantUML === | |||

==== About ==== | |||

* [https://www.plantuml.com PlantUML Web Server] | |||

* [https://plantuml.com/ja/ シンプルなテキストファイルで UML が書ける、オープンソースのツール] | |||

シンプルなテキストでUMLの作成ツール。ツールで機械的に生成できるのがポイント。細かいレイアウトの調整とか、複雑なことをしたい場合、けっこう難しくなる。 | |||

そうでなくて、機械的に作成することで、誰がやっても同じで、形式や配置が統一される。それが利点。 | |||

===== | ==== Other ==== | ||

===== 対話AI ===== | |||

自分で作成するより、対話AIにお願いして作ってもらって、それを改造する形で作るのが手っ取り早い模様。 | |||

シーケンス図やクラス図なんかはそれでいける。 | |||

==== VS Code ==== | |||

===== | ===== About ===== | ||

[https://qiita.com/Charotarou/items/10bd47c68a1190061858 Visual Studio CodeでPlantUMLを利用する方法(2020/10/30作成) #Java - Qiita] | |||

さっと書くだけなら、Webだけでもいい。機密情報とか扱う場合、ローカルでやるといい。 | |||

VSCodeの拡張機能でインストールする場合、JavaとGraphvizだけでいい。本体は拡張機能インストール時に同梱される模様。 | |||

===== 出力ディレクトリー ===== | |||

[https://oboe2uran.hatenablog.com/entry/2025/07/02/215013 VScode PlantUMLで作成するUML画像の出力先を設定する。 - Oboe吹きプログラマの黙示録] | |||

デフォルト状態だと、ファイル出力時に以下の形式になる。 | |||

out/.puファイル名/@startumlのタイトル.拡張子 | |||

最初のoutがうっとうしいのでpuと同じところに出力してほしい。 | |||

plantuml.exportOutDir: ".", | |||

plantuml.exportSubFolder: false, | |||

上記設定にするとよい。 | |||

==== ステート図/状態遷移図 ==== | |||

[https://plantuml.com/ja/state-diagram 状態遷移図の構文と機能] | |||

画面遷移図にも使える。 | |||

==== | ===== Alias ===== | ||

ステート・状態部分には、スペースや記号を使えない。以下の構文で別名を使って、表示用と内部用をわける。 | |||

state "display" as internal | |||

===== 合成状態 ===== | |||

状態は合成可能。ブロックにまとめたりできる。 state 状態名 {} で定義する。 | |||

@startuml | |||

scale 350 width | |||

[*] --> NotShooting | |||

state NotShooting { | |||

[*] --> Idle | |||

Idle --> Configuring : EvConfig | |||

Configuring --> Idle : EvConfig | |||

} | |||

state Configuring { | |||

[*] --> NewValueSelection | |||

NewValueSelection --> NewValuePreview : EvNewValue | |||

NewValuePreview --> NewValueSelection : EvNewValueRejected | |||

NewValuePreview --> NewValueSelection : EvNewValueSaved | |||

state NewValuePreview { | |||

State1 -> State2 | |||

} | |||

} | |||

@enduml | |||

共通処理を中でまとめたりするのに便利そう。 | |||

===== 画面遷移図 ===== | |||

https://chatgpt.com/share/6867298c-09bc-800b-89ec-de487215192b | |||

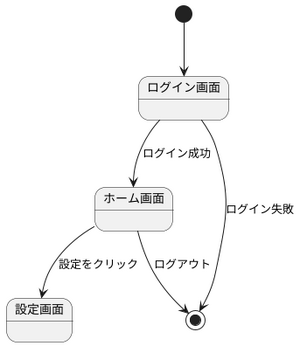

Webアプリケーションの設計書として、画面遷移図が必要なことがある。 | |||

UMLでやる場合、アクティビティー図か、ステート図 (状態遷移図) がうってつけ。画面とその遷移アクションの両方を記載できるので申し分ない。 | |||

他、一覧表もあり。 | |||

実際にいくつか状態遷移図をステートマシン図で書いてみたところ、問題があった。 | |||

共通ヘッダーやモーダルの表現が難しかった。コンポーネント化的なことができなくて、同じ画面遷移・状態を複数書く必要があった。モーダルを開いて閉じるというのは、repeatでループで表現できるが、他の画面遷移との併記が難しかった。 | |||

これを考えると、ステート図のほうが、矢印の方向が柔軟で、共通化なことができた。 | |||

ステートマシン図の例 | |||

[[ファイル:画面遷移図-ステートマシン図での例.png|なし|サムネイル|[*] --> ログイン画面ログイン画面 --> ホーム画面 : ログイン成功 | |||

ログイン画面 --> [*] : ログイン失敗 | |||

ホーム画面 --> 設定画面 : 設定をクリック | |||

ホーム画面 --> [*] : ログアウト]] | |||

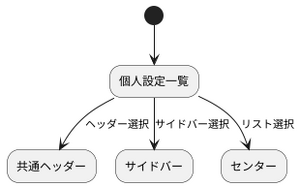

[ | アクティビティー図の例 | ||

[[ファイル:画面遷移図-アクティビティー図の例.png|なし|サムネイル|@startuml(*) --> 個人設定一覧 | |||

個人設定一覧 --> [ヘッダー選択] 共通ヘッダー | |||

個人設定一覧 --> [サイドバー選択] サイドバー | |||

個人設定一覧 --> [リスト選択] センター | |||

@enduml]]https://grok.com/share/c2hhcmQtMw%3D%3D_832592cf-86dd-41eb-a0fa-2fbd656e9299 | |||

ステート図で画面遷移図作成時のポイント。 | |||

Webページの場合はURLでやるのがいいと思う。 | |||

ただ、PlantUML内の状態名は、プログラミング言語の変数名相当だから、_以外の記号は使えない。 | |||

< | state <display> as <name> でnameを定義するといい。_をスラッシュとみなして、全小文字とか。 | ||

state "www.example.com" as wwww | |||

state "www.example.com/mypage" as www_mypage | |||

[*] -> www | |||

root -> www_mypage | |||

複数サイトになることがあるから、サブドメイン (なければwww) をベースの名前空間にするのがよさそう。 | |||

エイリアス名。url内の記号は除去でいい。exmaple.com/user-profile/editとか。www_userprofile_edit。url内のディレクトリーに記号を使うほうが悪い。全小文字区切り文字なしにすべき。短いほうがいいのだから。 | |||

===== 矢印の向き ===== | |||

矢印の向きの制御方法がある。 | |||

* ->: 最短距離。左右になることが多い。 | |||

* -right->/-down->/-up->/-left->: 向きを明示。 | |||

* -->: 長めの矢印。上下になることが多い。 | |||

* -->/..>: 向きには影響しない。 | |||

* top to bottom direction: 全体の向きの明示。 | |||

directionで全体の向きを指定しても、->の最短矢印だと、長さが優先される。矢印内で向きを明示するか、-->の長めの矢印を使うとよい。 | |||

===== 条件分岐 ===== | |||

<<choice>> ステレオタイプで条件付きの状態を指定できる。 | |||

@startuml | |||

state c <<choice>> | |||

Idle --> ReqId | |||

ReqId --> c | |||

c --> MinorId : [Id <= 10] | |||

@enduml | |||

やや使いにくいかもしれない。条件がある場合、矢印に説明を入れるといいかもしれない。 | |||

==== アクティビティー図 ==== | |||

[https://plantuml.com/ja/activity-diagram-beta 新しいアクティビティ図のベータ版の構文と機能] | |||

===== 記法 ===== | |||

https://chatgpt.com/share/68675652-ff90-800b-93ff-19285fe8cf21 | |||

PlantUMLのアクティビティー図の記法はレガシー記法とモダン記法とで2種類ある。 | |||

最大の違いは、分岐。以前は o --> option1, o --> option2で1個のアクティビティーから複数のアクティビティーに分岐できた。が、これがモダン記法だとできない。 | |||

split forkで明確に管理するようになった。パースとかのしやすさ、構文の曖昧性の排除が目的の模様。 | |||

===== split fork ===== | |||

アクティビティーの分岐の記法。2種類ある。紛らわしい。 | |||

splitは条件分岐、forkは並列実行的なイメージになっている。 | |||

以下の構文。 | |||

* split/split again/end split | |||

* fork/fork again/end fork | |||

@startuml | |||

start | |||

split | |||

:A; | |||

split again | |||

:B; | |||

split again | |||

:C; | |||

split again | |||

:a; | |||

:b; | |||

end split | |||

:D; | |||

end | |||

@enduml | |||

見た目の問題で、splitのほうがすっきりしている。 | |||

===== 矢印 ===== | |||

矢印にテキストを添えたり、色、線の形式を指定できる。<syntaxhighlight lang="text"> | |||

@startuml | |||

:foo1; | |||

-> You can put text on arrows; | |||

if (test) then | |||

-[#blue]-> | |||

:foo2; | |||

-[#green,dashed]-> The text can | |||

also be on several lines | |||

and **very** long...; | |||

:foo3; | |||

else | |||

-[#black,dotted]-> | |||

:foo4; | |||

endif | |||

-[#gray,bold]-> | |||

:foo5; | |||

@enduml | |||

</syntaxhighlight> | |||

===== モーダル ===== | |||

モーダルのような一時的に開いて戻る場合、反復可能なので、repeatで表現するとエレガント。 | |||

@startuml | |||

' PlantUMLソースコード | |||

start | |||

repeat :ホーム; | |||

->モーダルを開く; | |||

:モーダル; | |||

repeat while ([閉じる] 選択) is (yes) | |||

stop | |||

@enduml | |||

ただ、モーダル以外の他の画面遷移が少々苦しくなる。repeat内でsplitすればいけなくはないが。 | |||

モーダルを閉じる動きはstopでいいかもしれない。 | |||

==== ER図 ==== | |||

* [https://plantuml.com/ja/er-diagram Entity Relationship diagram (Chen's notation)] | |||

* [https://plantuml.com/ja/ie-diagram ER図の文法と機能] | |||

PlantUMLでは2種類のER図に対応している。Chen's notationは2024-04導入の新しい模様 ([https://github.com/plantuml/plantuml/blob/master/CHANGES.md#v120244-april-6-2024 plantuml/CHANGES.md at master · plantuml/plantuml])。 | |||

===== Chen notation ===== | |||

[https://plantuml.com/ja/er-diagram Entity Relationship diagram (Chen's notation)] | |||

chenの記法がER図そのものできれい。これを使う。ただ、Chen notationはnoteの注釈機能が使えなくて、見た目はいいけど、機能不十分。IEのほうがよさそう。 | |||

@startchen | |||

entity "DJ.CUSTOMER" as DJ_CUSTOMER { | |||

Number <<key>> | |||

Name | |||

} | |||

entity MOVIE { | |||

Code <<key>> | |||

} | |||

relationship RENTED_TO { | |||

Date | |||

} | |||

RENTED_TO =1= DJ_CUSTOMER | |||

RENTED_TO -N- MOVIE | |||

@endchen | |||

https://grok.com/share/c2hhcmQtMw%3D%3D_db38ab26-68a2-4a0b-b1e4-dc231e51279b | |||

* entity=テーブル。属性がなくても改行した波括弧が必要。少々気持ち悪いが。 | |||

* attribute=属性: entityの波括弧内に記述。<<key>>のステレオタイプでキーを表現。下線がつく。 | |||

* relationship=関係: has/belongs_toとかを記載するのが無難。user-order=places/student-courses=enrollsとかわかるなら動詞も。 | |||

** 太字 (total participation): 親テーブルに埋め込まれている外部キーがNOT NULLの場合。単独存在がなくて存在必須なので。 | |||

entity名に.とかは入れられないのでasで別名で回避 (https://grok.com/share/c2hhcmQtMw%3D%3D_1d81495e-fd3c-4f3c-8fc4-19b2d4f391b2<nowiki/>)。 | |||

https://grok.com/share/c2hhcmQtMw%3D%3D_aa8d7730-69dd-4d58-b88a-8edea922b3c8 | |||

属性はネストできる。これは概念的な話。例えば、住所は市区町村や番地、建物名とかに分解できる。が、物理DBだとこれらは展開済み。グループ化の話。別にネストしなくてもいい。 | |||

====== 親子関係 ====== | |||

オブジェクト指向の継承関係を表現できる。 | |||

* ->-: 矢印の方向が親。 | |||

@startchen | |||

entity CUSTOMER { | |||

} | |||

entity PARENT { | |||

} | |||

entity MEMBER { | |||

} | |||

CUSTOMER ->- PARENT | |||

MEMBER -<- CUSTOMER | |||

@endchen | |||

====== ステレオタイプ ====== | |||

* <<key>>: 主キー。 | |||

* <<derived>>: 他の属性からの計算カラム。 | |||

* <<multi>>: enum形式。 | |||

===== IE ===== | |||

[https://plantuml.com/ja/ie-diagram ER図の文法と機能] | |||

Information EngineeringベースのER図。既存のクラス図の拡張記法。クラス図でできることは全部できる。 | |||

classの代わりにentityを使うところが主な違い。 | |||

====== インフォメーションエンジニアリングの関係線 ====== | |||

{| class="wikitable" | |||

|'''Type''' | |||

|'''記号''' | |||

|- | |||

|0か1 | |||

|<code><nowiki>|o--</nowiki></code> | |||

|- | |||

|1のみ | |||

|<code><nowiki>||--</nowiki></code> | |||

|- | |||

|0以上 | |||

|<code>}o--</code> | |||

|- | |||

|1以上 | |||

|<code><nowiki>}|--</nowiki></code> | |||

|} | |||

波括弧}が複数。|が1、oが0を意味する。 | |||

関係線の記法だけ注意が必要。 | |||

====== エンティティ ====== | |||

基本はクラス図と同じ文法。他の違い。* は必須を意味する。 | |||

==== | ==== シーケンス図 ==== | ||

[https://plantuml.com/ja/sequence-diagram シーケンス図の構文と機能] | |||

->でメッセージを描く。参加者の明示的な宣言は不要。 | |||

===== 分類子の宣言 ===== | |||

参加者の宣言は不要だが、デフォルトだと四角になる。actorとかDatabaseとか見た目を調整したい場合、participantでを宣言しておく。 | |||

変数の型名のように、以下の分類子 | |||

* <code>actor</code> | |||

* <code>boundary</code> | |||

* <code>control</code> | |||

* <code>entity</code> | |||

* <code>database</code> | |||

* <code>collections</code> | |||

* <code>queue</code> | |||

* participant (初期値) | |||

<分類子> <参加者>[ as 別名] | |||

@startuml | |||

participant Participant as Foo | |||

actor Actor as Foo1 | |||

boundary Boundary as Foo2 | |||

control Control as Foo3 | |||

entity Entity as Foo4 | |||

database Database as Foo5 | |||

collections Collections as Foo6 | |||

queue Queue as Foo7 | |||

Foo -> Foo1 : To actor | |||

Foo -> Foo2 : To boundary | |||

Foo -> Foo3 : To control | |||

Foo -> Foo4 : To entity | |||

Foo -> Foo5 : To database | |||

Foo -> Foo6 : To collections | |||

Foo -> Foo7: To queue | |||

@enduml | |||

===== メッセージに付けるノート ===== | |||

メッセージのすぐ後ろにキーワード note left または note right を使用し、メッセージにノートを付けることが可能です。 | |||

==== | end note キーワードを使って、複数行のノートを作ることができます。 | ||

@startuml | |||

Alice->Bob : hello | |||

note left: this is a first note | |||

Bob->Alice : ok | |||

note right: this is another note | |||

Bob->Bob : I am thinking | |||

note left | |||

a note | |||

can also be defined | |||

on several lines | |||

end note | |||

@enduml | |||

===== メッセージのグループ化 ===== | |||

===== | 次のキーワードを使えば、メッセージをまとめてグループ化できます。 | ||

alt/else | |||

opt | |||

loop | |||

par | |||

break | |||

critical | |||

group表示するテキスト | |||

ヘッダ部分に文字列を追加することが可能です。(groupについては、後述の「groupの2つ目のラベル」を参照) | |||

グループを閉じるにはキーワード end を使用します。 | |||

@startuml | |||

Alice -> Bob: Authentication Request | |||

alt successful case | |||

Bob -> Alice: Authentication Accepted | |||

else some kind of failure | |||

Bob -> Alice: Authentication Failure | |||

group My own label | |||

Alice -> Log : Log attack start | |||

loop 1000 times | |||

Alice -> Bob: DNS Attack | |||

end | |||

Alice -> Log : Log attack end | |||

end | |||

else Another type of failure | |||

Bob -> Alice: Please repeat | |||

end | |||

@enduml | |||

<code>group</code>では、<code>[</code>と<code>]</code>の間に2つ目のラベルを設定し、ヘッダに表示させることができます。 | |||

@startuml | |||

Alice -> Bob: Authentication Request | |||

Bob -> Alice: Authentication Failure | |||

group My own label [My own label 2] | |||

Alice -> Log : Log attack start | |||

loop 1000 times | |||

Alice -> Bob: DNS Attack | |||

end | |||

Alice -> Log : Log attack end | |||

end | |||

@enduml | |||

===== ライフラインの活性化と破棄 ===== | |||

activateとdeactivateで分類子の活性化を表現。例えば、関数の実行中とかが四角になってわかりやすい。 | |||

が、やや記述が複雑になるので注意する。 | |||

@startuml | |||

participant User | |||

User -> A: DoWork | |||

activate A | |||

A -> B: << createRequest >> | |||

activate B | |||

B -> C: DoWork | |||

activate C | |||

C --> B: WorkDone | |||

destroy C | |||

B --> A: RequestCreated | |||

deactivate B | |||

A -> User: Done | |||

deactivate A | |||

@enduml | |||

autoactivate onにすると勝手に活性化してくれる。returnで解除する。昔はなかった気がする。このautoactivate on。 | |||

ただ、これを使うと、途中でif文でreturnする倍とかの表現が面倒になるので注意する。 | |||

@startuml | |||

autoactivate on | |||

alice -> bob : hello | |||

bob -> bob : self call | |||

bill -> bob #005500 : hello from thread 2 | |||

bob -> george ** : create | |||

return done in thread 2 | |||

return rc | |||

bob -> george !! : delete | |||

return success | |||

@enduml | |||

returnを使うと自動的に活性化してくれるのでこれを活用するのがいい。 | |||

@startuml | |||

Bob -> Alice : hello | |||

activate Alice | |||

Alice -> Alice : some action | |||

return bye | |||

@enduml | |||

===== | ===== 活性化、非活性化、生成のショートカット記法 ===== | ||

対象の分類子を記述した直後に、次の記法を使うことができます。 | |||

* <code>++</code> 対象を活性化する (続けて[[/plantuml.com/ja/color|色]]を記述することもできます) | |||

* <code>--</code> 起点側を非活性化する | |||

* <code>**</code> 対象のインスタンスを生成する | |||

* <code>!!</code> 対象のインスタンスを破棄する | |||

==== クラス図 ==== | |||

[https://plantuml.com/ja/class-diagram クラス図の構文と機能] | |||

===== メソッド ===== | |||

クラス名:に続けて記載する。他に波括弧。 | |||

丸括弧があればメソッド。なければプロパティー。 | |||

@startuml | |||

Object <|-- ArrayList | |||

Object : equals() | |||

ArrayList : Object[] elementData | |||

ArrayList : size() | |||

@enduml | |||

@startuml | |||

class Dummy { | |||

String data | |||

void methods() | |||

} | |||

class Flight { | |||

flightNumber : Integer | |||

departureTime : Date | |||

} | |||

@enduml | |||

===== 可視性 ===== | |||

{| class="wikitable" | |||

|'''文字''' | |||

|'''可視性''' | |||

|- | |||

|<code>-</code> | |||

|<code>private</code> | |||

|- | |||

|<code>#</code> | |||

|<code>protected</code> | |||

|- | |||

|<code>~</code> | |||

|<code>package private</code> | |||

|- | |||

|<code>+</code> | |||

|<code>public</code> | |||

|} | |||

===== 注釈とステレオタイプ ===== | |||

===== 注釈の詳細 ===== | |||

===== | ===== フィールド(フィールド、属性、メンバー)またはメソッドへの注釈 ===== | ||

フィールド (フィールド、属性、メンバー) に注釈を追加できる。 | |||

left/rightのみ可能。名前空間区切り文字列に::を指定した場合、使用不能。 | |||

@startuml | |||

class A { | |||

{static} int counter | |||

+void {abstract} start(int timeout) | |||

} | |||

note right of A::counter | |||

This member is annotated | |||

end note | |||

note right of A::start | |||

This method is now explained in a UML note | |||

end note | |||

@enduml | |||

以下の書式。 | |||

note <direction> of <class>::<attribute> | |||

end note | |||

インラインは不能。 | |||

==== Reference ==== | |||

[https://plantuml.com/ja/guide PlantUML Language Reference Guide] | |||

===== | ===== Creole ===== | ||

[https://plantuml.com/ja/creole Use creole syntax to style your texts] | |||

====== | ====== 特殊文字 ====== | ||

&#XXXXまたは、<U+XXXX>の構文、または直接記述することで、任意のUnicode文字を使うことができます。 | |||

らしいが、&#XXXX形式は解釈されなかった。<U+XXXX>は有効だった。 | |||

[ | [https://blog.jawira.com/2022/10/30/escaping-special-characters-in-plantuml.html Escaping special characters in PlantUML | Jawira blog] | ||

noteのブロックの先頭に'を書きたい場合、コメント扱いされてしまう。 | |||

<U+0027>でユニコード文字表記にすれば回避できる。 | |||

===== 21 共通コマンド ===== | |||

[https://plantuml.com/ja/commons General and common command to handle graphic layout in diagrams.] | |||

====== コメント ====== | |||

* シングルコメント: シングルクォート'で始まる行はコメント。 | |||

* ブロックコメント: C言語と同様だが/' '/ で囲む。 | |||

====== タイトル ====== | |||

title タイトル | |||

title | |||

end title | |||

タイトル部分は\nで改行できる。他にブロック形式だと改行を含められる。 | |||

====== キャプション ====== | |||

captionでキャプション。 | |||

====== | ====== フッターとヘッダー ====== | ||

footer/headerブロック。 | |||

====== 凡例 ====== | |||

legend/end legend | |||

====== 21.9 メインフレーム ====== | |||

mainframe This is a **mainframe* | |||

タイトルみたいに枠で囲んでくれて見た感じがよくなる。 | |||

===== 25 前処理 ===== | |||

====== 25.5 プロシージャー [!procedure, !endprocedure] ====== | |||

テキストを出力する。 | |||

====== 25.6 return関数 [!function, !endfunction] ====== | |||

[https://messykitchen.hateblo.jp/entry/2022-05-23_plantuml_function_procedure マクロの扱い [脱W〇rd, 脱E×cel, 脱@st@h : #14] - messyなkitchenなブログ] | |||

過去の!define相当。テキストの値として使う。 | |||

=== Umbrello === | |||

== | ==== Problem ==== | ||

altなどの重なり順番、アクティブの下になっちゃう | |||

optの条件が表示されない。 | |||

=== Papyrus === | |||

[https://eclipse.dev/papyrus/download.html Papyrus Dowloads] | |||

[https://eclipse.dev/papyrus/documentation.html Papyrus Documentation] | |||

==== Tutorial ==== | |||

公式の[A slide-ware tutorial on Eclipse Papyrus usage for starters (2010-10-01)]を参考に基本的な使い方を学ぶ。 | |||

[File]-[New]-[Papyrus prooject] | |||

これでプロジェクトを作ると、以下が [Project Explorer] に作られる。 | |||

* <project name> | |||

** <project name> | |||

*** di: ツールメタデータ。モデル作成のエントリーポイント。 | |||

*** notation: 画像データ。 | |||

*** uml: UMLモデルデータ。 | |||

このdiをダブルクリックして描画を開始する。 | |||

1個のプロジェクトでいろんな図に対応していて、モデルを流用できる形になっている。悪くない。これを使う。 | |||

画面構成 | |||

# Project explorer | |||

# Model explorer: 一番重要。ここでモデル全体をツリーベースで管理する。 | |||

# Outline view: アウトライン | |||

# Main toolber: ツールバー。 | |||

# Perspective: Model explorerの内容を使って作図する領域。 | |||

# Property view: モデルのエディター画面。 | |||

Model explorerがPapyrusの本質。ここでクラスとかインタラクションを定義しておいて、この定義をperspectiveの作図に使うイメージ。 | |||

クラス図やシーケンス図もModel explorerに所属していて、好きなだけ作れる。[New diagram]から作れる。 | |||

[New Child] でいくつか重要なモデルがある。 | |||

* | * Package: ディレクトリ・フォルダーみたいなもの。これで他のモデルをまとめて整理できる。 | ||

* | * Interaction: シーケンス図表現用のモデル。 | ||

* Class: クラス。Interactionの型だったりする。UMLのベースで非常に重要。 | |||

==== Class ==== | |||

===== 属性表示 ===== | |||

クラス図にクラスモデルを配置しても、プロパティーやメソッドが表示されない。 | |||

右クリック-[Filters] で制御できる。 | |||

* [ | * [Synchronized with Model] を選ぶと同期されて全部表示される。基本はこれで、一部だけ表示したい場合にここを外すのだろうと思う。 | ||

* [ | * [Show/Hide Contents] で表示可否をチェックボックスで選べる。 | ||

===== Modelへのジャンプ ===== | |||

クラス図などからオブジェクトのModel Explorerの元データにジャンプしたいことがある。 | |||

オブジェクト右クリック-[Navigate]-[Go to ...]-[Model Explorer] を選ぶ。 | |||

===== | ===== Comment ===== | ||

https://chatgpt.com/c/67aec9f8-6be0-800b-b6eb-6300425ad1d4 | |||

メソッドなどにコメントを入れたいことがある。このコメントがわかりにくい。 | |||

[Properties]-[Comments]-[Owned comments]-[Body] に入力する。初回+で作ったダイアログのBodyに入力したものは反映されなくて、一度空のコメントを作った後に、洗濯後横のBodyに入力すると反映される模様。 | |||

[ | |||

* Applied comments=他のモデルのコメントを取り込みたい場合に使う。 | |||

* Owned comments=自分自身のコメント。コメントに対してコメントをつけることもできるので、[Create a new Comment] はさらに [Comments] タブを持っている。このタブがコメントのコメント。基本は使う必要ない。 | |||

[Annotated element] でたぶん、Bodyに入力したコメントを複数の要素に適用したい場合の適用先だと思う。 | |||

==== | ==== Sequence diagrams ==== | ||

https://eclipse.dev/papyrus/resources/PapyrusTutorial_OnSequenceDiagrams_v0.1_d2010100.pdf | |||

===== | ===== 2.2 Adding messages (basic - asynchronous) ===== | ||

コミュニケーションは、メッセージの交換で描写される。 | |||

メッセージはoperationCall (同期/非同期) かsignal (非同期) コミュニケーションとして表現される。 | |||

synchronousCall作成時は、replyMessageも期待される。 | |||

createMessageとdeleteMesageの指定は、ライフラインの動的な有無を意味する。 | |||

Papyrusでのメッセージ作成は以下の手順で構成される。 | |||

# パレットからツールを選択。 | |||

# ソースLifelineの開始点をクリック。 | |||

# ターゲットLifelineの終了点をクリック。 | |||

# ポップアップの該当するsignal/operationを選択。 | |||

記法 | |||

* 非同期メッセージは中抜き矢尻 (arrow head)。 | |||

* 同期メッセージは塗りつぶし矢尻。 | |||

* 返信メッセージは波線 (dashed line)。 | |||

* オブジェクト作成メッセージは波線+中抜き矢尻。 | |||

* Lost Messageは黒丸矢尻。 | |||

* Found Messageは黒丸矢柄。 | |||

===== | ====== 2.2.1 Select desired tool from the palette ====== | ||

* Message SyncとMessage Replyは [Execution Specifications] がないと使えない。 | |||

* Message createはターゲットポイントが存在時に使用可能。 | |||

====== 2.2.2 Select source and target points ====== | |||

ソースとターゲットポイントは2の異なるライフライン (通常) か、同じライフライン (再帰) が選択可能。 | |||

ターゲットポイントの制限は、対象の要素に依存する。例えば、Synchronous CallはExecution Specificationから始まる必要がある。 | |||

===== | ===== 2.3 Adding execution specification ===== | ||

ここまでのシーケンス図では、通信シナリオだけを想定してきた。が、実際には、完全な実行トレースを表現できる。Execution Specification (ES) は実行を表す抽象概念で、Action Execution SpecificationとBehavior Execution Specificationの2種類がある。 | |||

PapyrusではライフラインにESをセットして行う。ESをセットしたら、同期メッセージを追加できる。 | |||

開発プロセスでは、予備設計では全メッセージを非同期とみなしておいて、設計時にESを設定して、同期メッセージをする感じ。 | |||

ただ、同期メッセージは、応答メッセージが入ってごちゃごちゃする。単にシーケンス図を書くだけなら、非同期で全部書いてもいいと思う。 | |||

===== Undoで破損 ===== | |||

シーケンス図を作成して、削除のUndoを何回かやると、データが破損して開けなくなる。対応方法不明。GitでPapyrusのファイルを管理しておいて、破損に対応しておいた方がいい。 | |||

===== | ===== 再帰自己呼び出しシーケンス図 ===== | ||

シーケンス図の描画に癖があるので、方針を固めて使用する。 | |||

# 自己関数の呼び出しはMessage Async/Message Reply。Message Syncは期待通りに配置されないので、自己関数には使わない。他のライフラインには使う。 | |||

# 関数の呼び出し期間はAction Execution Specificationを配置。 | |||

# 矢印の端にESを配置する形にする。 | |||

===== オブジェクトの移動 ===== | |||

オブジェクトの移動に癖がある。基本的に、メッセージは始点、終点で別々に移動させるしかない。まとめて選択して一括移動ができない。 | |||

終点を移動させると、その下のオブジェクトも追随する。追加はこれで対応できる。減らすのは手間になる。 | |||

シーケンス図が大きくなりすぎないように注意する。 | |||

==== | == Coding == | ||

- | === タイムゾーン === | ||

[https://qiita.com/dmikurube/items/15899ec9de643e91497c タイムゾーン呪いの書 #timezone - Qiita] | |||

3文字形式は避けたほうが無難。 | |||

タイムゾーン名で判定する実装があるので、UTC-9なども避けたほうがいい。 | |||

====== | tz databaseのAsia/Tokyoなどの確実性が高い。 | ||

=== Regular Expression === | |||

* | * [https://ja.wikipedia.org/wiki/%E6%AD%A3%E8%A6%8F%E8%A1%A8%E7%8F%BE 正規表現 - Wikipedia] | ||

* [https://pubs.opengroup.org/onlinepubs/9699919799.2008edition/basedefs/V1_chap09.html Regular Expressions] | |||

* | |||

正規表現。重要。覚えにくいが重要なものをメモしておく。 | |||

==== BRE ==== | |||

===== BREs Matching Multiple Characters ===== | |||

複数文字に一致するBREを作成する記法 (量指定子) がある。 | |||

単一文字、部分式、後方参照のいずれかに一致するBREの後に、'\{m\}', '\{m,\}', '\{m,n\}' の形式の配置で、指定回数の連続に一致する。 | |||

* mとnの範囲: 0<=m<=n<={RE_DUP_MAX}の範囲の10進数。 | |||

* mは最小出現回数、nは最大出現回数。 | |||

* \{m\}: m回出現 | |||

* \{m,\}: m回以上 | |||

* \{m,n\}: m-n回出現 | |||

例: abababccccccdに対する"c\{3^}"は7-9文字目でマッチ。 | |||

{| class="wikitable" | |||

|+単一文字の量指定子 | |||

|<code>*</code> | |||

|<code>{0,}</code> と同じ | |||

|- | |||

|<code>+</code> | |||

|<code>{1,}</code> と同じ | |||

|- | |||

|<code>?</code> | |||

|<code>{0,1}</code> と同じ | |||

|} | |||

====== | ===== POSIXクラス ===== | ||

言語によって、アルファベット順が違うことがある。エストニア語ではsの後にzがあり、[a-z]では全ての英字にマッチしない。ロケールに依存する。 | |||

= | これの排除のために、文字の区分を定義している。 | ||

[ | {| class="wikitable" | ||

|+ | |||

!POSIXクラス | |||

!対応正規表現 | |||

!意味 | |||

|- | |||

|<nowiki>[[:upper:]]</nowiki> | |||

| | |||

| | |||

|- | |||

|<nowiki>[[:lower:]]</nowiki> | |||

| | |||

| | |||

|- | |||

|<nowiki>[[:alpha:]]</nowiki> | |||

| | |||

| | |||

|- | |||

|<nowiki>[[:alnum:]]</nowiki> | |||

| | |||

| | |||

|- | |||

|<nowiki>[[:digit:]]</nowiki> | |||

| | |||

| | |||

|- | |||

|<nowiki>[[:xdigit]]</nowiki> | |||

| | |||

| | |||

|- | |||

|<nowiki>[[:punct:]]</nowiki> | |||

| | |||

| | |||

|- | |||

|<nowiki>[[:blank:]]</nowiki> | |||

|[ \t] | |||

|スペースとタブ。 | |||

|- | |||

|<nowiki>[[:space:]]</nowiki> | |||

|[ \t\n\r\f\v] | |||

|スペースとタブ+改行類。 | |||

|- | |||

|<nowiki>[[:cntrl:]]</nowiki> | |||

| | |||

| | |||

|- | |||

|<nowiki>[[:graph:]]</nowiki> | |||

| | |||

| | |||

|- | |||

|<nowiki>[[:print:]]</nowiki> | |||

| | |||

| | |||

|} | |||

特に以下が重要。 | |||

* <nowiki>[[:alnum:]]</nowiki> | |||

* <nowiki>[[:space:]]</nowiki> | |||

[:X:]が[]内で使える構文の扱い。組み合わせる場合、[[:upper:]ab]という感じで外側各括弧に収める。 | |||

==== ERE ==== | |||

基本はBREと同じ。エスケープ\が不要になっている。 | |||

多くのプログラミング言語などでは、EREが基本。grep -E相当。 | |||

=== | ==== PCRE ==== | ||

* [https://www.php.net/manual/ja/reference.pcre.pattern.syntax.php PHP: PCRE 正規表現構文 - Manual] | |||

* [https://www.pcre.org/current/doc/html/pcre2syntax.html pcre2syntax specification] | |||

EREをさらに以下で拡張したもの。 | |||

* POSIXクラスの拡張表現の文字クラス | |||

* | * 量指定子の追加構文 (+ ?) | ||

* | * 言明/assertion | ||

===== 量指定子/Quantifiers ===== | |||

? 0 or 1, greedy | |||

?+ 0 or 1, possessive | |||

?? 0 or 1, lazy | |||

* 0 or more, greedy | |||

*+ 0 or more, possessive | |||

*? 0 or more, lazy | |||

+ 1 or more, greedy | |||

++ 1 or more, possessive | |||

+? 1 or more, lazy | |||

{n} exactly n | |||

{n,m} at least n, no more than m, greedy | |||

{n,m}+ at least n, no more than m, possessive | |||

{n,m}? at least n, no more than m, lazy | |||

{n,} n or more, greedy | |||

{n,}+ n or more, possessive | |||

{n,}? n or more, lazy | |||

{,m} zero up to m, greedy | |||

{,m}+ zero up to m, possessive | |||

{,m}? zero up to m, lazy | |||

BRE/EREで登場した量指定子。デフォルトではgreedy (貪欲) マッチで、最長マッチ。 | |||

量指定子の末尾に?で最短マッチ (lazy)。 | |||

量指定子の末尾に+で独占的 (possessive)。マッチを消費する。処理の高速化になる。 | |||

==== | ===== 言明/assertion ===== | ||

* [https://www.php.net/manual/ja/regexp.reference.anchors.php PHP: アンカー - Manual] | |||

[https:// | * [https://www.php.net/manual/ja/regexp.reference.assertions.php PHP: 言明 - Manual] | ||

言明 (assertion) はカレントマッチング位置の直前・直後の文字に対するテスト、条件付け。文字を消費しない。テストのみ。 | |||

if文相当。直接マッチしないで、条件へのマッチ。マッチ対象文字を消費しない。 | |||

正規表現内で、if文相当の条件判定する際に使用する。 | |||

BREの段階で^$ (アンカー/anchor) があった。これの大幅拡張。 | |||

例えば、フォームの検証で「特定文字種が含まれていること」+9-12文字のような複数の条件指定を実現できる。 | |||

複雑な言明はサブパターン (言明サブパターン/assetion subpattern) を用いる。カレント位置の先と後とで2種類ある。 | |||

====== anchors ====== | |||

^ start of subject | |||

also after an internal newline in multiline mode | |||

(after any newline if PCRE2_ALT_CIRCUMFLEX is set) | |||

$ end of subject | |||

also before newline at end of subject | |||

also before internal newline in multiline mode | |||

==== | ====== simple assertions ====== | ||

\b word boundary | |||

\B not a word boundary | |||

\A start of subject | |||

\Z end of subject | |||

also before newline at end of subject | |||

\z end of subject | |||

\G first matching position in subject | |||

====== LOOKAHEAD AND LOOKBEHIND ASSERTIONS ====== | |||

(?=...) ) | |||

(*pla:...) ) positive lookahead | |||

(*positive_lookahead:...) ) | |||

(?!...) ) | |||

(*nla:...) ) negative lookahead | |||

(*negative_lookahead:...) ) | |||

(?<=...) ) | |||

(*plb:...) ) positive lookbehind | |||

(*positive_lookbehind:...) ) | |||

(?<!...) ) | |||

(*nlb:...) ) negative lookbehind | |||

(*negative_lookbehind:...) ) | |||

肯定否定。=で肯定、!で否定。 | |||

* (?: 先読み。言明の次、右側を判定。 | |||

* (?<: 戻読み。言明の前、左側を判定。 | |||

先読み言明 (lookahead assertion) | |||

例えば、以下のパターンはセミコロンが後に続く単語にマッチする。 | |||

\w+(?=;) | |||

言明は複数同じ場所に配置可能で、AND条件になる。ORにしたかったら、(?<=abc|abde) のように選択肢にする。 | |||

以下はbarが後ろに続かないfooにマッチする。 | |||

foo(?!bar) | |||

以下はfoo以外の後のbarではない。 | |||

(?!foo)bar | |||

全部のbarにマッチする。この言明の直後の3文字がbarの場合、(?!foo)が常に真になるから。 | |||

言明の先読みは、基本は右端に配置する。右端の後に何か続ける場合、\w+とか使う。言明自体は文字を消費しないから、言明部分をカバーできるタイプの文字クラスの併用が必要。 | |||

echo preg_match('/foo(?=bar)\w+$/', 'foobar.'); # 0 | |||

==== Case ==== | |||

後ろからマッチ。cが置換対象。 | |||

/[^c]*$/ | |||

cより右端 | |||

===== | ===== マッチの前後の挿入 ===== | ||

https:/vim.fandom.com/wiki/Power_of_g | |||

:g/GST_.*("/s/^/LOG(INFO) << "DEBUG";/r/ | |||

行頭・行末で引っ掛ける。 | |||

==== | ===== 関数にログ ===== | ||

:%s/([^")]*)/) /([a-z]* /)*{/&/rLOG(INFO) << "/1";/r/g | |||

考慮するケース | |||

double currentTime() const override { return m_element->currentTime(); } | |||

===== | ===== フォーム検証 ===== | ||

https://grok.com/share/c2hhcmQtMw%3D%3D_0c3a03bf-35f1-4594-a5d8-21673072ada5 | |||

英字と数字がそれぞれ1文字以上、かつ9-12文字。 | |||

=== | 戻読み言明と量指定を併用する。 | ||

$password = "123456333d78"; // テスト用のパスワード | |||

$options = [ | |||

'options' => [ | |||

'regexp' => '/^(?=.*<nowiki>[[:alpha:]]</nowiki>)(?=.*\d).{9,12}$/' | |||

] | |||

]; | |||

if (filter_var($password, FILTER_VALIDATE_REGEXP, $options)) { | |||

echo "パスワードは有効です。"; | |||

} else { | |||

echo "パスワードが条件を満たしていません。"; | |||

ただ、filter_inputだと検証失敗の理由まで特定して取得できない。面倒だが1個ずつやるしかない。関数化すれば1回で済む。 | |||

==== | === glob === | ||

* [https://pubs.opengroup.org/onlinepubs/9699919799.2008edition/functions/glob.html glob] | |||

* [https://pubs.opengroup.org/onlinepubs/9699919799.2008edition/utilities/V3_chap02.html#tag_18_13 Shell Command Language] | |||

重要。正規表現とは似ているが異なる、パターンマッチング記法 (Pattern Matching Notation)。主に、globで採用されており、ディレクトリー・ファイルのマッチングで使われる。 | |||

使用可能な記号は以下3個。以下の3文字は\でエスケープできる。 | |||

* ?: 任意の1文字にマッチ。 | |||

* *: 任意の0以上の文字にマッチ。 | |||

* [: []内の1文字にマッチ。正規表現の各括弧と同じ。ただし、先頭の否定が^ではなく、!。 | |||

ファイル名マッチ時には、追加で特殊なルールがある。 | |||

.から始まるファイル名へのマッチには、.が必要。つまり、*?は先頭の.にはマッチしない。[!a] のような否定形の各括弧記法も.にはマッチしない。加えて、先頭の[.]もマッチするかは不定(unspecified)。 | |||

globで.ファイルを含めたい場合、工夫が必要 ([https://www.php.net/manual/ja/function.glob.php PHP: glob - Manual])。 | |||

[https:// | .[!.]* * | ||

上記のように.ファイルのマッチとそれ以外を指定する必要がある。 | |||

<code>.[!.]*</code> は、<code>.</code>と<code>..</code>以外の.<code>.</code>始まりのファイルにマッチする。 | |||

<code>.*</code>を指定すると、<code>.</code>/<code>..</code>がマッチするので注意する。最近のシェルは、シェル側で気を利かせているようで、<code>.*</code>だと<code>.</code> /<code>..</code>はマッチしない。 | |||

=== | === 引用符のネスト === | ||

シェルやプログラミング言語で、文字列リテラルの表現などで、一重引用符'と二重引用符"を使う。 | |||

JSON作成や変数展開などで、これらをネストさせたいことがある。その基本的な考え方を整理する。 | |||

交互にしていい場合は簡単二重。引用符内に一重引用符を配置、一重引用符内に二重引用符を配置すればいい。 | |||

問題はこれがNGな場合。特にありがちなのが、JSONの生成。JSONの引用符は二重引用符のみ。一重引用符の中だと、二重引用符の変数展開が使用不能。外側を二重引用符にする必要がある。 | |||

二重引用符は、内部で変数展開が可能。この都合で、バックスラッシュ\によるエスケープが有効。 | |||

基本的な方法。 | |||

# 既存の一重/二重引用符などをバックスラッシュでエスケープ。 | |||

# 全体を一重/二重引用符で囲む。 | |||

何かAwkの本か何かで、基本的な考え方の説明の記載があった気がする。 | |||

[{"ke\y":"valu\e"}] を例として考える。 | |||

# {"ke\y":"valu\e"} | |||

# エスケープ: {\"ke\\y\":\"valu\\e\"} | |||

# 全体囲み: "{\"ke\\y\":\"valu\\e\"}" | |||

これでOK。また何か考慮不足があればそのときに考える。 | |||

ただ、元データに修正が必要なので、そのまま行きたい。ヒアドキュメント的なものが使えるならそれを使うのがいい。 | |||

例えば、シェルなら、catコマンドとコマンド置換で生テキストを使える。 | |||

echo $(cat <<-'EOT' | |||

{"ke\y":"valu\e"} | |||

EOT | |||

) | |||

.envなどで使える技?いや使えない。.envではシンプルなコマンドしか使えず、ヒアドキュメントは使えない模様。 | |||

* [https://stackoverflow.com/questions/15637429/how-to-escape-double-quotes-in-json How to escape double quotes in JSON - Stack Overflow] | |||

* [https://stackoverflow.com/questions/64011248/how-to-handle-double-quotes-in-json-value python - How to handle double quotes in JSON value? - Stack Overflow] | |||

JSONのvalue部分に適用したい場合。データの二重引用符をバックスラッシュでエスケープする。これはこうするしかない。JSONが二重引用符しか認めないから。 | |||

# | 基本的な考え方がある。 | ||

# JSON value用に二重引用符"を\"で置換。 | |||

# \"がPHP/JavaScriptで二重引用符に扱いにならないように、\を\\に置換。 | |||

# JSON項目の二重引用符"を\"で置換。 | |||

# 全体を二重引用符"で囲む。 | |||

こういう感じ。JSONはawkでも任意の最終データで考える。途中にプログラミング言語でのパースがあるので、それを考慮する必要がある。 | |||

=== ケース変換 === | |||

[https://stackoverflow.com/questions/63116039/camelcase-to-kebab-case javascript - camelCase to kebab-case - Stack Overflow] | |||

キャメルケースをチェインケースにしたり、逆にしたりなどケース変換したいことがある。正規表現を駆使して実現する。 | |||

=== encode === | |||

[https://www.sejuku.net/blog/25909 【PHP入門】URLエンコードする方法(urlencode) | 侍エンジニアブログ] | |||

日本語や記号を他のコードに変換 (エンコード) する方式が何通りかある。把握しておくと役立つ。 | |||

= | * パーセントエンコーディング/URLエンコード: URLで使用不能な文字を%16進数で連結。 | ||

* UTF-8 | |||

* base64: 全データを「A-Z」「a-z」「0-9」「+」「/」の64文字で表現。文末に=を使うので実質は65文字。 | |||

* HTMLエンコード: HTMLで特殊な意味を持つ文字を&lt;などに変換する。 | |||

==== Percent-encoding ==== | |||

* [https://ja.wikipedia.org/wiki/%E3%83%91%E3%83%BC%E3%82%BB%E3%83%B3%E3%83%88%E3%82%A8%E3%83%B3%E3%82%B3%E3%83%BC%E3%83%87%E3%82%A3%E3%83%B3%E3%82%B0 パーセントエンコーディング - Wikipedia] | |||

* [https://developer.mozilla.org/ja/docs/Glossary/Percent-encoding Percent-encoding (パーセントエンコーディング) - MDN Web Docs 用語集: ウェブ関連用語の定義 | MDN] | |||

* [https://datatracker.ietf.org/doc/html/rfc3986 RFC 3986 - Uniform Resource Identifier (URI): Generic Syntax] | |||

unreserved = ALPHA / DIGIT / "-" / "." / "_" / "~" | |||

上記文字はエンコードの対象外。 | |||

== | ==== 英数変換 ==== | ||

[https://stackoverflow.com/questions/28110062/php-how-to-encode-all-characters-with-rawurlencode string - PHP How to encode all characters with rawurlencode - Stack Overflow] | |||

変数名への変換などで、日本語や記号を英数字 [0-9a-zA-Z] に変換したいことがある。 | |||

こういう目的だと%エンコーディングが適している。 | |||

== | ただし、一部の記号を許可しているので、自前で変換する。 | ||

function encode_all($str) { | |||

$hex = unpack('H*', $str); | |||

return preg_replace('~..~', '%$0', strtoupper($hex[1])); | |||

} | |||

$str = 'big ƒüßchen'; | |||

print_r(encode_all($str)); | |||

==== Term ==== | |||

紛らわしい用語がある。 | |||

* [https:// | * ミドルウェア: 名前通り中間のソフトウェア。DBやアプリケーションサーバーなどが該当。単独で動作が重要なポイント ([https://sackle.co.jp/blog/detail/1248-2 ミドルウェアとは何か?代表的な製品や使用例とあわせて解説! - サックルMAGAZINE]、[https://system-kanji.com/posts/middleware-development ミドルウェアとは?アプリ・システム開発との関係・仕組み・役割・具体例を解説【2024年最新版】 | システム幹事])。 | ||

* フレームワーク: 単体で動作しない。アプリ開発のテンプレート。Django/Ruby on Rails/Vue.jsなど ([https://www.pentasecurity.co.jp/pentapro/entry/framework_library 【3分ITキーワード】 フレームワークとライブラリの違いは? - ペンタPRO:ペンタセキュリティが提供するセキュリティ情報まとめサイト])。 | |||

* ライブラリー: 単体で動作しない。よく使われるコードの集まり。機能単位。jQuery/Numpy/matplotlib/Qtなど。 | |||

フレームワークの中にライブラリーも含めていいと思う。 | |||

「[https://webbigdata.jp/what-is-ai/page-6804/page-8359/page-12091/ Pythonのモジュールとパッケージとライブラリとフレームワークの違い]」がわかりやすい。 | |||

フレームワークはライブラリーを含んでいる。ライブラリーで共通でいいと思う。 | |||

==== Category ==== | |||

「[https://ja.wikipedia.org/wiki/%E3%82%BD%E3%83%95%E3%83%88%E3%82%A6%E3%82%A7%E3%82%A2%E9%96%8B%E7%99%BA%E5%B7%A5%E7%A8%8B ソフトウェア開発工程 - Wikipedia]」 | |||

ソフトウェアの分類、ページ分類時に役立つ。 | |||

* 言語 | |||

* ツール: 静的解析、テスト、文書など。 | |||

* フレームワーク | |||

MediaWikiのページ名は全体で固有が条件なので、言語名+分類名でページを作るといい。 | |||

例 | |||

* PHP language | |||

* PHP tool | |||

* PHP framework | |||

==== 成功時連続継続処理 ==== | |||

一度の取得件数の上限が決まっていて、終了・失敗するまで取得を継続したいという処理がそれなりに発生する。 | |||

# 処理実行。 | |||

# 成功ならA、失敗なら終了。 | |||

# 処理実行。 | |||

# 成功ならA、失敗なら終了。 | |||

こういうパターン。いくつか実装方法があるが、while (true) のパターンが重複がなくてベストだと思う。 | |||

/* | |||

// 無限ループで終了条件でブレイク | |||

while (true) { | |||

// 処理実行 | |||

if (失敗) { | |||

break; | |||

} | |||

成功時処理 | |||

} | |||

// do while | |||

* | do { | ||

処理実行 | |||

if (成功時) {} | |||

} while (); | |||

// for (初期化; 継続判定・終了判定; 成功時式) { | |||

処理実行 | |||

} | |||

*/ | |||

do-whileは成功・終了判定を2回書く必要がある。 | |||

forだと成功処理を式でしか書けない。成功処理を関数や即時実行関数式などで書くなら悪くはないし、ベストになりえる。 | |||

いや、成功時処理内の処理の結果次第で反復の終了条件などが追加で入るならNGになる。なので、やっぱりwhile(true)が無難。コード行数もそんなに変わらない。 | |||

これにさらに初回だけ、ヘッダーの取得、書き込み処理などが発生する場合、初回だけループの外でやるのがきれいだろうか?初回処理が2回登場することになるけれど。 | |||

offsetなどで初回の判定が反復内でできるから、それで分けるのがいいか? | |||

$offset = 0; | |||

while (true) { | |||

=== | $currentReturnCode = $service->sendRequest(Raku2Config::API_TYPE_CSV_EXPORT, Raku2Config::CONFIG_API_URL_MULTI_API, [ | ||

json_encode([ | |||

'dbSchemaId' => $table_info['dbSchemaId'], | |||

'offset' => $offset, | |||

'limit' => $limit, | |||

]) | |||

]); | |||

$response = $service->getApiResultJson(); | |||

// 終了条件: 戻り値が成功以外、か応答本体が1行 (ヘッダーのみ) の時。 | |||

if (($currentReturnCode !== Raku2Config::EXIT_SUCCESS) || (substr_count($response, "\n") <= 1)) break; | |||

// 2回目からはヘッダー除去して書き込み。 | |||

$start = strpos($response, "\n") + 1; | |||

$flat = FILE_APPEND; | |||

if ($offset === 0) { | |||

$start = $flag = 0; | |||

$path = stream_get_meta_data($fp = tmpfile())['uri']; | |||

} | |||

file_put_contents($path, substr($response, $start), $flag); | |||

$offset += $limit; | |||

sleep(3); | |||

} | |||

for ($offset = 0; | |||

($currentReturnCode === Raku2Config::EXIT_SUCCESS) && (substr_count($response, "\n") > 1); | |||

(function() use (&$offset, $limit, $response) { | |||

// 2回目からはヘッダー除去して書き込み。 | |||

$start = strpos($response, "\n") + 1; | |||

$flag = FILE_APPEND; | |||

if ($offset === 0) { | |||

$start = $flag = 0; | |||

$path = stream_get_meta_data($fp = tmpfile())['uri']; | |||

} | |||

file_put_contents($path, substr($response, $start), $flag); | |||

$offset += $limit; | |||

sleep(3); | |||

})() | |||

) { | |||

$currentReturnCode = $service->sendRequest(Raku2Config::API_TYPE_CSV_EXPORT, Raku2Config::CONFIG_API_URL_MULTI_API, [ | |||

json_encode([ | |||

'dbSchemaId' => $table_info['dbSchemaId'], | |||

'offset' => $offset, | |||

'limit' => $limit, | |||

]) | |||

]); | |||

$response = $service->getApiResultJson(); | |||

} | |||

=== character === | |||

=== | ==== BOM ==== | ||

UTF-8のBOM | |||

\xef\xbb\xbf | |||

この文字を先頭につけるとUTF-8のBOMになる。 | |||

==== | === Convert === | ||

==== IP/CIDR ==== | |||

// JavaScript | |||

<nowiki> </nowiki> /** | |||

<nowiki> </nowiki> * サブネットマスクをIPアドレス形式 (x.x.x.x/255.255.255.0) からCIDR形式 (x.x.x.x/24) に変換する。 | |||

<nowiki> </nowiki> * @param {string} ipaddress - IPアドレス文字列 (x.x.x.x/x.x.x.x形式)。 | |||

<nowiki> </nowiki> */ | |||

=== | <nowiki> </nowiki> toCIDR(ipaddress) { | ||

<nowiki> </nowiki> const [address, mask] = ipaddress.split('/') | |||

<nowiki> </nowiki> const segments = mask.split('.') | |||

<nowiki> </nowiki> const CIDR = segments | |||

<nowiki> </nowiki> .map((e) => Number(e).toString(2)) | |||

<nowiki> </nowiki> .join(<nowiki>''</nowiki>) | |||

<nowiki> </nowiki> .replace(/0*$/, <nowiki>''</nowiki>).length | |||

<nowiki> </nowiki> return address + '/' + CIDR | |||

<nowiki> </nowiki> }, | |||

<nowiki> </nowiki> /** | |||

<nowiki> </nowiki> * サブネットマスクのCIDR形式 (24) をIPアドレス形式 (255.255.255.0)に変換する。 | |||

<nowiki> </nowiki> * @param {number} cidr - ciderの数字。 | |||

<nowiki> </nowiki> * @return {string} x.x.x.x形式のIPアドレス文字列。 | |||

<nowiki> </nowiki> */ | |||

<nowiki> </nowiki> cidrToIp(cidr) { | |||

<nowiki> </nowiki> const digit = 32 | |||

<nowiki> </nowiki> const ip = ('1'.repeat(cidr) + '0'.repeat(digit)).substr(0, digit) | |||

<nowiki> </nowiki> return ip | |||

<nowiki> </nowiki> .match(/.{8}/g) | |||

<nowiki> </nowiki> .map((e) => parseInt(e, 2)) | |||

<nowiki> </nowiki> .join('.') | |||

<nowiki> </nowiki> }, | |||

=== Algorithm === | |||

==== 再帰処理 ==== | |||

https://chatgpt.com/c/673d9bfe-2414-800b-9922-f94be6dbe950 | |||

配列の配列、オブジェクトのオブジェクトなど、再帰的な構造はけっこう遭遇する。 | |||

再帰関数で実装するほかに、スタックで処理する方法がある。 | |||

再帰関数のほうが簡単に実装できるが、関数呼び出しのオーバーヘッドがある。ネスト10-100程度くらいなら問題ない。 | |||

パフォーマンスや再帰中の細かい制御が必要なら、スタックが有利。ただし、実装がやや複雑。 | |||

最初は再帰関数で実装して、後でボトルネックになったらスタックというのも手。 | |||

https://chatgpt.com/c/6745228f-8b20-800b-8a41-bdaece8c03f5 | |||

再帰関数とスタックの他に、JSONなどの文字列にシリアライズして、文字列処理で対応するという手もある。 | |||

JSONPath/XPathなどの方法もあるが、基本的には外部ライブラリーが必要。 | |||

シンプルなケース以外は、再帰関数で処理したほうが結局シンプルな感じがする。 | |||

=== Other === | |||

==== コメントの著者名 ==== | |||

https://chatgpt.com/c/67469d8d-7e64-800b-b82d-8c74f4e13c08 | |||

GNU socialのソースコードのコメントに著者名が大量にあった鬱陶しい。 | |||

大規模プロジェクトになると、編集者が膨大になる。VCSに任せて、本文には記載しなくていいと思う。 | |||

git blameで行単位で編集者が分かる。 | |||

==== 確率処理 ==== | |||

https://chatgpt.com/share/68145e5c-9d14-800b-9cca-1cd9e46e2dd6 | |||

ある確率で処理をしたり、しなかったりしたいことがある。 | |||

$chance = 30; // 30%の確率 | |||

if (mt_rand(1, 100) <= $chance) { | |||

// 30%の確率でここに入る | |||

echo "当たり!"; | |||

} else { | |||

// 70%の確率でこっちに入る | |||

echo "はずれ..."; | |||

} | |||

乱数を作成して、それで確率値の超過判定で表現できる。 | |||

=== | === Architecture === | ||

==== About ==== | |||

https://grok.com/share/c2hhcmQtMw%3D%3D_d762a384-9703-4539-b8e7-022bc680d88f | |||

* MVC | |||

* MVVM | |||

* クリーンアーキテクチャー | |||

このあたりが有名。MVCが一番無難。MVCでは厳しいような大規模になったら、他を検討する価値がある感じ。 | |||

==== Clean Architecture ==== | |||

クリーンアーキテクチャー。最近よく聞く設計手法。 | |||

* [https://zenn.dev/muno/articles/introduce-clean-architecture クリーンアーキテクチャに入門する] | |||

* https://chatgpt.com/share/6870b175-d394-800b-a885-b41600d128cd | |||

「[https://blog.cleancoder.com/uncle-bob/2011/11/22/Clean-Architecture.html Clean Coder Blog]」で2011-11-22にRobert C. Martinによって提唱さえたアーキテクチャー。ソフトウェアの開発・展開・運用・保守を簡単にして、プログラマーの生産性の最大化が目的。 | |||

多くのアーキテクチャーでは、関心を分離して、異なる役割や責務を分離して、変更の影響を最小限にしている。これの実現に、ソフトウェアをレイヤー (層) に分けている。クリーンアーキテクチャーは、このアイデアの1個のガイドラインになっている。 | |||

中心にビジネスルールがあって、玉ねぎのように、中心から外に向かって、層構造になっている。 | |||

# エンティティ: ビジネスロジック (ドメイン層)。外部の影響 (FWの更新など) に影響を受けない。 | |||

# ユースケース: アプリのビジネスルール。interface adapterから受け取ったデータをもとに、entityのビジネスロジックを組み合わせて、アプリ特有のロジックを実現。 | |||

# Interface Adapter (Controller/Gateway/Presenter): 外部システムと内部システムのデータを変換する。例えば、コントローラーはリクエストをUsecaseが利用できる形式に変換 (4->2) し、プレゼンターはユースケースの出力を外部システムが理解できる形式に変換 (2->4) する。 | |||

# Framework/Driver (DB/Device/Web Framework/UI/外部Web API): WebアプリケーションFW、DBなど。外部エージェントとの通信処理。基本的にはライブラリーやFWを使う。 | |||

基本はこれだけ。 | |||

既存のMVC型アプリをクリーンアーキテクチャーにする場合の対応。 | |||

* | * Controller: Interface adapter | ||

* | * Model: Entity (domain/repository interface) | ||

* View: Framework | |||

* | |||

たまねぎの層構造の表現は、ディレクトリーの親子関係で表現できるときれいなんだけど。層ごとでグループ化したり、継承したりする場合に、ディレクトリーを作れなくて困る。大規模になるならなおさら。 | |||

中小規模や、うまく分割してきれいにまとめられるならあり。 | |||

一般的には、機能を最上位において、その下で4の層をディレクトリーで配置するというのが多い模様。 | |||

src/ | |||

└── Article/ | |||

├── Domain/ | |||

├── Application/ | |||

├── Interface/ | |||

└── Infrastructure/ | |||

==== SSR+CSR ==== | |||

===== About ===== | |||

https://chatgpt.com/c/6747e923-6174-800b-8816-dd741721de45 | |||

バックエンドとフロントエンドの分離の話。 | |||

SPA (Single Page Application) やJAMStackの影響で、バックエンドはデータを返すだけで、画面描画はフロントエンドが全部する (CSR) というのが最近の流行。 | |||

SSR (Server Side Rendering) とCSR (Client Side Rendering) の違い。フロントエンドの高度化や分業などが理由とのこと。 | |||

SSRの利点。 | |||

* SEO | |||

* 初期表示。 | |||

* 匿名。 | |||

SSRの課題。 | |||

* サーバー負荷: データとHTML作成を同時に行うから。 | |||

* 分散困難: | |||

キャッシュの活用がポイントになるとのこと。 | |||

===== リダイレクト ===== | |||

https://chatgpt.com/share/6886c2c2-b5cc-800b-8e03-e301c22d5eff | |||

CSRでやる場合、最終的にCSRの成果物をstaticに生成して、それをサーバー側のpublicに配置する感じになる。 | |||

npm run generateの生成先をpublicに直接してもOKだと思う。いや、これは既存のindex.phpとかが消えるのでまずい。シンボリックリンクにするとか。 | |||

1台でフロントとサーバーの両方を扱う場合、/apiなどサーバーリクエストに使うURLはindex.phpに、それ以外はindex.htmlなどにするようなリダイレクト設定が必要。 | |||

以下のようなイメージ。 | |||

<IfModule mod_rewrite.c> | |||

<IfModule mod_negotiation.c> | |||

Options -MultiViews -Indexes | |||

</IfModule> | |||

RewriteEngine On | |||

# Handle Authorization Header | |||

RewriteCond %{HTTP:Authorization} . | |||

RewriteRule .* - [E=HTTP_AUTHORIZATION:%{HTTP:Authorization}] | |||

# Send Requests To Front Controller... | |||

RewriteCond %{REQUEST_URI} ^/(api|sanctum)(/|$) | |||

RewriteRule ^ index.php [L] | |||

# Nuxtのビルド済み静的ファイル (_nuxt/) は除外 | |||

RewriteCond %{REQUEST_URI} ^/_nuxt/ | |||

RewriteRule ^ - [L] | |||

# RewriteCond %{REQUEST_FILENAME} !-f [OR] | |||

RewriteCond %{REQUEST_FILENAME} !-d | |||

RewriteRule ^ - [L] | |||

RewriteRule ^ index.html [L] | |||

</IfModule> | |||

=== Naming === | |||

==== Code ==== | |||

=== | ===== camelCase ===== | ||

https://gnusocial.jp/notice/7694551 | |||

!it 命名規則のキャメルケース。これ英語前提です。関数名に英語以外を使うと破綻します。 | |||

getキーバリュー()みたいな関数の定義。日本語ですると境界がわからなくなるので、getキー_バリューみたいにアンダーバーで区切ったほうが分かりやすい。なるほど… | |||

===== getMyVariable() vs myVariable() ===== | |||

* [https://stackoverflow.com/questions/3532828/php-methods-getmyvariable-vs-myvariable naming conventions - PHP methods: getMyVariable() vs myVariable() - Stack Overflow] | |||

* [https://stackoverflow.com/questions/139427/which-coding-convention-to-follow-for-php Which Coding convention to follow for PHP? - Stack Overflow] | |||

getterとsetterの命名規則。 | |||

getVar()にするか、Var()にするか。C++だと後者のパターンがあったりする。getを省略できるので、省スペースになる。 | |||

ただ、コード補完で探しやすさがちょっと変わる。getを前置したほうがわかりやすいか。 | |||

===== namePrefixed() vs prefixedName() ===== | |||

https://chatgpt.com/c/673bd358-3dc8-800b-8ec9-d745cc0eba85 | |||

名詞+修飾語 (形容詞) の場合のメソッドの命名規則。name+修飾語が複数ある場合name+修飾語がいい。オブジェクト指向でnameをオブジェクトとして扱う形に近い。name.methodみたいな。 | |||

例えば、nameMax、nameMinのような場合は後ろのほうが都合がいい。ただ、こういう場合はそもそもnameをオブジェクトにしてname.max()、name.min()にしたほうがいいという説がある。 | |||

そうではないならば、getPrefixedName()などが自然。getQueryString()など。StringQueryではない。 | |||

PHPでは以下のような命名規則が好まれる。 | |||

* 動詞+修飾対象=getPrefixedName/isPrefixed() | |||

* 修飾対象+状態/修飾語=prefixdName | |||

getPrefixedNameがいいか。後置修飾にしたいならば、そもそもオブジェクト+メソッドにすることを検討する。 | |||

===== map ===== | |||

連想配列とかハッシュ、オブジェクトなどでキーバリュー形式のデータ構造を扱うことがある。そういう変数の命名規則。 | |||

<code>map_[key]_[value]</code> のような形式にすると、キーとバリューが何を意味するか分かってわかりやすい。 | |||

https://chatgpt.com/c/67ca84e0-9018-800b-9674-035ae9f4bbaf | |||

* [key]_[value]_map | |||

* [key]_to_[value] | |||

上記のどちらかがいいだろう。toがkey_valueの区切りが明示的でいいかもしれない。 | |||

===== | ===== array/foreach ===== | ||

* [https:// | * [https://wiki.senooken.jp/PHP#Name_2 PHP - senooken JP Wiki] | ||

* https://chatgpt.com/c/6747aee4-ab64-800b-88d7-940a5c4201bf | |||

= | foreach系のfor文ではキーとバリューを変数に格納して反復する。ファイルや配列に対して行うことが多い。 | ||

foreach (table as $row => $line) | |||

その際の変数名は、上記のように$row/$lineにすると、行番号と行の値がはっきりしてわかりやすい。 | |||